Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

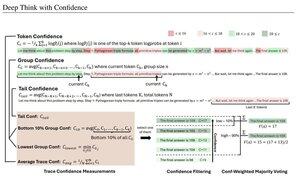

Прості достовірні заходи базуються на середній ймовірності логарифмічного спостереження, що використовується для фільтрації слідів міркувань. Знову ж таки, дуже гарне дослідження, яке стало можливим завдяки доступу до високоякісних моделей з відкритим вихідним кодом.

Шукайте все більш і більш потужні пайплайни з архітектурою «генератор-верифікатор», яка знижує погані результати. Верифікатором може бути екземпляр моделі або якась математична функція на кшталт метрик внутрішньої впевненості, розроблених у цій роботі. Існуючі моделі дуже потужні при використанні з таким типом конвеєра та великими бюджетами токенів. (Тут токени ~1E8 використовуються для AIME 2025.)

«DeepConf використовує сигнали впевненості всередині моделі, щоб динамічно відфільтровувати сліди низькоякісних міркувань під час або після генерації. Він не вимагає додаткового навчання моделі або налаштування гіперпараметрів і може бути легко інтегрований в існуючі рамки обслуговування. Ми оцінюємо DeepConf за допомогою різноманітних завдань міркувань і останніх моделей з відкритим вихідним кодом, включаючи серії Qwen 3 і GPT-OSS. Примітно, що на складних тестах, таких як AIME 2025, DeepConf@512 досягає точності до 99,9% і зменшує кількість згенерованих токенів до 84,7% порівняно з повним паралельним мисленням».

Зверніть увагу на іронію в тому, що ці дослідники Meta використовують моделі ОС Qwen, GPT-OSS і DeepSeek, але не Llama 😢

23 серп., 04:00

Представляємо DeepConf: Глибоке мислення з упевненістю

🚀 Перший метод досягти 99,9% на AIME 2025 за допомогою моделей з відкритим вихідним кодом! Використовуючи GPT-OSS-120B навіть без інструментів, ми досягли цієї майже ідеальної точності, зберігаючи до 85% згенерованих токенів.

Це також дає багато сильних переваг для паралельного мислення:

🔥 Підвищення продуктивності: точність ~10% для моделей і наборів даних

⚡ Надефективний: до 85% менше згенерованих токенів

🔧 Plug & play: працює з БУДЬ-ЯКОЮ існуючою моделлю - не потрібно тренуватися (також без налаштування гіперпараметрів!)

⭐ Легко розгортати: всього ~50 рядків коду в vLLM (див. PR нижче)

📚 Папір:

🌐 Проект:

Спільна робота з: @FuYichao123 , xuewei_wang @tydsh

(подробиці дивіться в коментарях нижче)

5K

Найкращі

Рейтинг

Вибране