Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Простые меры уверенности, основанные на среднем логарифмическом вероятности, используются для фильтрации следов рассуждений. Еще раз, очень хорошее исследование, обеспеченное доступом к высококачественным моделям с открытым исходным кодом.

Ожидайте все более мощные конвейеры с архитектурой "генератор-проверяющий", которая отсекает плохие результаты. Проверяющий может быть экземпляром модели или какой-то математической функцией, такой как внутренние метрики уверенности, разработанные в этой статье. Существующие модели очень мощные, когда используются с таким типом конвейера и большими бюджетами токенов. (Здесь ~1E8 токенов использовано для AIME 2025.)

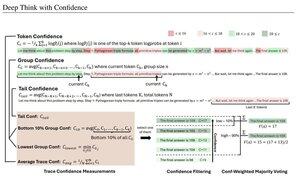

"DeepConf использует внутренние сигналы уверенности модели для динамической фильтрации низкокачественных следов рассуждений во время или после генерации. Он не требует дополнительного обучения модели или настройки гиперпараметров и может быть бесшовно интегрирован в существующие фреймворки обслуживания. Мы оцениваем DeepConf по различным задачам рассуждений и последним моделям с открытым исходным кодом, включая Qwen 3 и серию GPT-OSS. Примечательно, что на сложных контрольных точках, таких как AIME 2025, DeepConf@512 достигает до 99.9% точности и снижает количество сгенерированных токенов до 84.7% по сравнению с полным параллельным мышлением."

Обратите внимание на иронию этих исследователей Meta, использующих модели с открытым исходным кодом Qwen, GPT-OSS и DeepSeek, но не Llama 😢

23 авг., 04:00

Представляем DeepConf: Глубокое мышление с уверенностью

🚀 Первый метод для достижения 99.9% на AIME 2025 с использованием открытых моделей! Используя GPT-OSS-120B даже без инструментов, мы достигли этой почти идеальной точности, сэкономив до 85% сгенерированных токенов.

Это также предоставляет множество сильных преимуществ для параллельного мышления:

🔥 Увеличение производительности: ~10% точности по моделям и наборам данных

⚡ Ультраэффективность: до 85% меньше сгенерированных токенов

🔧 Подключи и работай: Работает с ЛЮБОЙ существующей моделью - нулевое обучение не требуется (также без настройки гиперпараметров!)

⭐ Легкость развертывания: всего ~50 строк кода в vLLM (см. PR ниже)

📚 Статья:

🌐 Проект:

совместная работа с: @FuYichao123 , xuewei_wang, @tydsh

(см. детали в комментариях ниже)

5K

Топ

Рейтинг

Избранное