Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ukuran keyakinan sederhana berdasarkan probabilitas log rata-rata yang digunakan untuk memfilter jejak penalaran. Sekali lagi, penelitian yang sangat bagus dimungkinkan oleh akses ke model open source berkualitas tinggi.

Carilah pipeline yang semakin kuat dengan arsitektur "generator-verifier" yang memangkas hasil buruk. Verifikator dapat berupa contoh model, atau semacam fungsi matematika seperti metrik kepercayaan internal yang dikembangkan dalam makalah ini. Model yang ada sangat kuat ketika digunakan dengan pipeline semacam ini dan anggaran token yang besar. (Di sini, ~1E8 token digunakan untuk AIME 2025.)

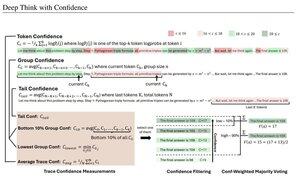

"DeepConf memanfaatkan sinyal kepercayaan internal model untuk secara dinamis menyaring jejak penalaran berkualitas rendah selama atau setelah generasi. Ini tidak memerlukan pelatihan model tambahan atau penyetelan hiperparameter dan dapat diintegrasikan dengan mulus ke dalam kerangka kerja penyajian yang ada. Kami mengevaluasi DeepConf di berbagai tugas penalaran dan model sumber terbuka terbaru, termasuk seri Qwen 3 dan GPT-OSS. Khususnya, pada tolok ukur yang menantang seperti AIME 2025, DeepConf@512 mencapai akurasi hingga 99,9% dan mengurangi token yang dihasilkan hingga 84,7% dibandingkan dengan pemikiran paralel penuh."

Perhatikan ironi peneliti Meta ini menggunakan model OS Qwen, GPT-OSS, dan DeepSeek, tetapi tidak ada Llama 😢

23 Agu, 04.00

Memperkenalkan DeepConf: Berpikir Mendalam dengan Percaya Diri

🚀 Metode pertama untuk mencapai 99.9% di AIME 2025 dengan model sumber terbuka! Menggunakan GPT-OSS-120B bahkan tanpa alat, kami mencapai akurasi yang hampir sempurna ini sambil menghemat hingga 85% token yang dihasilkan.

Ini juga memberikan banyak keuntungan kuat untuk pemikiran paralel:

🔥 Peningkatan kinerja: ~10% akurasi di seluruh model & kumpulan data

⚡ Sangat efisien: Token yang dihasilkan hingga 85% lebih sedikit

🔧 Plug & play: Bekerja dengan model yang ada APAPUN - tidak diperlukan pelatihan (tidak ada penyetelan hiperparameter juga!)

⭐ Mudah diterapkan: Hanya ~50 baris kode di vLLM (lihat PR di bawah)

📚 Kertas:

🌐 Proyek:

Bekerja bersama dengan: @FuYichao123, xuewei_wang, @tydsh

(lihat detail di komentar di bawah)

5K

Teratas

Peringkat

Favorit