Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

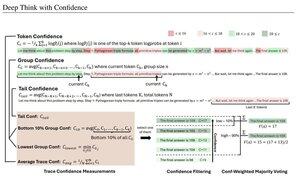

Măsurători simple de încredere bazate pe probabilitatea logaritmică medie utilizate pentru a filtra urmele de raționament. Încă o dată, cercetare foarte frumoasă permisă de accesul la modele open source de înaltă calitate.

Căutați conducte din ce în ce mai puternice cu arhitectură "generator-verificator" care elimină rezultatele proaste. Verificatorul poate fi o instanță model sau un fel de funcție matematică, cum ar fi valorile interne de încredere dezvoltate în această lucrare. Modelele existente sunt foarte puternice atunci când sunt utilizate cu acest tip de conductă și bugete mari de token-uri. (Aici, ~1E8 jetoane folosite pentru AIME 2025.)

"DeepConf folosește semnalele de încredere interne ale modelului pentru a filtra dinamic urmele de raționament de calitate scăzută în timpul sau după generare. Nu necesită antrenament suplimentar al modelului sau reglarea hiperparametrilor și poate fi integrat fără probleme în cadrele de servire existente. Evaluăm DeepConf printr-o varietate de sarcini de raționament și cele mai recente modele open-source, inclusiv seriile Qwen 3 și GPT-OSS. În special, pe benchmark-uri provocatoare, cum ar fi AIME 2025, DeepConf@512 atinge o precizie de până la 99,9% și reduce tokenurile generate cu până la 84,7% în comparație cu gândirea paralelă completă."

Observați ironia acestor cercetători Meta folosind modele de sistem de operare Qwen, GPT-OSS și DeepSeek, dar nu Llama 😢

23 aug., 04:00

Vă prezentăm DeepConf: Gândiți profund cu încredere

🚀 Prima metodă de a obține 99,9% la AIME 2025 cu modele open-source! Folosind GPT-OSS-120B chiar și fără instrumente, am atins această precizie aproape perfectă, economisind până la 85% token-uri generate.

De asemenea, oferă multe avantaje puternice pentru gândirea paralelă:

🔥 Creșterea performanței: ~10% precizie între modele și seturi de date

⚡ Ultra-eficient: Cu până la 85% mai puține jetoane generate

🔧 Plug & play: Funcționează cu ORICE model existent - nu este nevoie de antrenament (nici reglarea hiperparametrilor!)

⭐ Ușor de implementat: Doar ~50 de linii de cod în vLLM (vezi PR mai jos)

📚 Hârtie:

🌐 Proiect:

lucru comun cu: @FuYichao123 , xuewei_wang @tydsh

(vezi detalii în comentariile de mai jos)

5K

Limită superioară

Clasament

Favorite