熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

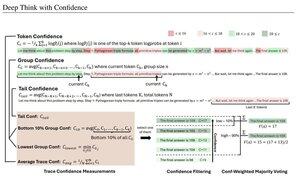

基於平均對數概率的簡單信心度量用於過濾推理軌跡。再次強調,得益於高質量開源模型的訪問,這項研究非常出色。

期待越來越強大的管道,採用"生成器-驗證器"架構來修剪不良結果。驗證器可以是模型實例,或者某種數學函數,比如本文中開發的內部信心度指標。現有模型在與這種管道和大令牌預算結合使用時非常強大。(在這裡,AIME 2025使用了大約1E8個令牌。)

"DeepConf利用模型內部的信心信號,在生成過程中或之後動態過濾低質量的推理軌跡。它不需要額外的模型訓練或超參數調整,可以無縫集成到現有的服務框架中。我們在各種推理任務和最新的開源模型上評估DeepConf,包括Qwen 3和GPT-OSS系列。值得注意的是,在AIME 2025等具有挑戰性的基準測試中,DeepConf@512的準確率高達99.9%,並且與完全並行思維相比,生成的令牌減少了多達84.7%。"

注意這些Meta研究人員使用開源模型Qwen、GPT-OSS和DeepSeek,但沒有使用Llama的諷刺 😢

8月23日 04:00

介紹 DeepConf:自信地深思

🚀 首個使用開源模型在 AIME 2025 上實現 99.9% 的方法!即使沒有工具,使用 GPT-OSS-120B,我們也達到了幾乎完美的準確率,同時節省了多達 85% 的生成令牌。

它還為並行思維提供了許多強大的優勢:

🔥 性能提升:模型和數據集的準確率提高約 10%

⚡ 超高效:生成的令牌減少多達 85%

🔧 即插即用:與任何現有模型兼容 - 無需訓練(也無需超參數調整!)

⭐ 易於部署:在 vLLM 中只需 ~50 行代碼(見下面的 PR)

📚 論文:

🌐 項目:

與以下人員共同合作:@FuYichao123 , xuewei_wang, @tydsh

(請查看下面的評論中的詳細信息)

4.99K

熱門

排行

收藏