Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

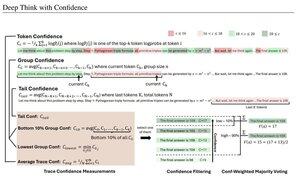

Des mesures de confiance simples basées sur la probabilité logarithmique moyenne utilisées pour filtrer les traces de raisonnement. Encore une fois, une très belle recherche rendue possible grâce à l'accès à des modèles open source de haute qualité.

Recherchez des pipelines de plus en plus puissants avec une architecture "générateur-vérificateur" qui élimine les mauvais résultats. Le vérificateur peut être une instance de modèle, ou une sorte de fonction mathématique comme les métriques de confiance internes développées dans cet article. Les modèles existants sont très puissants lorsqu'ils sont utilisés avec ce type de pipeline et de grands budgets de tokens. (Ici, ~1E8 tokens utilisés pour AIME 2025.)

"DeepConf exploite les signaux de confiance internes au modèle pour filtrer dynamiquement les traces de raisonnement de faible qualité pendant ou après la génération. Il ne nécessite aucun entraînement de modèle supplémentaire ni réglage d'hyperparamètres et peut être intégré sans problème dans les frameworks de service existants. Nous évaluons DeepConf à travers une variété de tâches de raisonnement et les derniers modèles open source, y compris Qwen 3 et la série GPT-OSS. Notamment, sur des benchmarks difficiles tels que AIME 2025, DeepConf@512 atteint jusqu'à 99,9 % de précision et réduit les tokens générés jusqu'à 84,7 % par rapport à une pensée parallèle complète."

Notez l'ironie de ces chercheurs de Meta utilisant des modèles open source Qwen, GPT-OSS et DeepSeek, mais pas de Llama 😢

23 août, 04:00

Présentation de DeepConf : Pensez profondément avec confiance

🚀 Première méthode pour atteindre 99,9 % sur AIME 2025 avec des modèles open-source ! En utilisant GPT-OSS-120B même sans outils, nous avons atteint cette précision presque parfaite tout en économisant jusqu'à 85 % de tokens générés.

Cela offre également de nombreux avantages pour la pensée parallèle :

🔥 Amélioration des performances : ~10 % de précision en plus sur les modèles et les ensembles de données

⚡ Ultra-efficace : Jusqu'à 85 % de tokens générés en moins

🔧 Plug & play : Fonctionne avec N'IMPORTE quel modèle existant - aucune formation nécessaire (pas de réglage d'hyperparamètres non plus !)

⭐ Facile à déployer : Juste ~50 lignes de code dans vLLM (voir PR ci-dessous)

📚 Article :

🌐 Projet :

travail conjoint avec : @FuYichao123 , xuewei_wang, @tydsh

(voir les détails dans les commentaires ci-dessous)

4,99K

Meilleurs

Classement

Favoris