Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

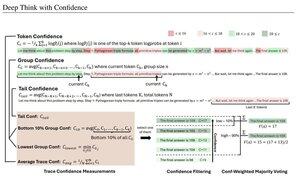

Medidas de confianza simples basadas en la probabilidad logarítmica promedio utilizadas para filtrar los rastros de razonamiento. Una vez más, una investigación muy buena habilitada por el acceso a modelos de código abierto de alta calidad.

Busque canalizaciones cada vez más potentes con una arquitectura de "generador-verificador" que reproduzca los malos resultados. El verificador puede ser una instancia de modelo o algún tipo de función matemática como las métricas de confianza internas desarrolladas en este documento. Los modelos existentes son muy poderosos cuando se usan con este tipo de canalización y grandes presupuestos de tokens. (Aquí, ~1E8 tokens utilizados para AIME 2025).

"DeepConf aprovecha las señales de confianza internas del modelo para filtrar dinámicamente los rastros de razonamiento de baja calidad durante o después de la generación. No requiere entrenamiento adicional del modelo ni ajuste de hiperparámetros y se puede integrar sin problemas en los marcos de servicio existentes. Evaluamos DeepConf en una variedad de tareas de razonamiento y los últimos modelos de código abierto, incluidas las series Qwen 3 y GPT-OSS. En particular, en puntos de referencia desafiantes como AIME 2025, DeepConf@512 logra hasta un 99,9% de precisión y reduce los tokens generados hasta en un 84,7% en comparación con el pensamiento paralelo completo".

Tenga en cuenta la ironía de estos investigadores de Meta que usan modelos de sistema operativo Qwen, GPT-OSS y DeepSeek, pero no Llama 😢

23 ago, 04:00

Presentamos DeepConf: Deep Think with Confidence

🚀 ¡Primer método para lograr el 99,9% en AIME 2025 con modelos de código abierto! Usando GPT-OSS-120B incluso sin herramientas, alcanzamos esta precisión casi perfecta mientras ahorramos hasta un 85% de tokens generados.

También ofrece muchas ventajas importantes para el pensamiento paralelo:

🔥 Aumento del rendimiento: ~10% de precisión en todos los modelos y conjuntos de datos

⚡ Ultraeficiente: hasta un 85% menos de tokens generados

🔧 Plug & play: Funciona con CUALQUIER modelo existente - no se necesita entrenamiento (¡no se necesita ajuste de hiperparámetros también!)

⭐ Fácil de implementar: solo ~ 50 líneas de código en vLLM (consulte PR a continuación)

📚 Papel:

🌐 Proyecto:

Trabajo conjunto con: @FuYichao123 , xuewei_wang, @tydsh

(ver detalles en los comentarios a continuación)

4.99K

Populares

Ranking

Favoritas