Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

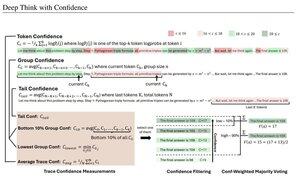

Eenvoudige vertrouwensmaatregelen gebaseerd op gemiddelde logkans die worden gebruikt om redeneertraces te filteren. Nogmaals, zeer mooi onderzoek mogelijk gemaakt door toegang tot hoogwaardige open source modellen.

Zoek naar steeds krachtigere pipelines met een "generator-verifier" architectuur die slechte resultaten wegfiltert. De verifier kan een modelinstantie zijn, of een soort wiskundige functie zoals de interne vertrouwensmetrics die in dit artikel zijn ontwikkeld. Bestaande modellen zijn zeer krachtig wanneer ze worden gebruikt met dit soort pipelines en grote tokenbudgetten. (Hier, ~1E8 tokens gebruikt voor AIME 2025.)

"DeepConf maakt gebruik van interne vertrouwenssignalen van het model om dynamisch laagwaardige redeneertraces tijdens of na generatie te filteren. Het vereist geen extra modeltraining of hyperparameterafstemming en kan naadloos worden geïntegreerd in bestaande serveerframeworks. We evalueren DeepConf over een verscheidenheid aan redeneertaken en de nieuwste open-source modellen, waaronder Qwen 3 en de GPT-OSS serie. Opmerkelijk is dat DeepConf@512 op uitdagende benchmarks zoals AIME 2025 tot 99,9% nauwkeurigheid bereikt en het aantal gegenereerde tokens met tot 84,7% vermindert in vergelijking met volledige parallelle denkwijzen."

Let op de ironie van deze Meta-onderzoekers die OS-modellen Qwen, GPT-OSS en DeepSeek gebruiken, maar geen Llama 😢

23 aug, 04:00

Introductie van DeepConf: Diep Denken met Vertrouwen

🚀 De eerste methode om 99,9% te behalen op AIME 2025 met open-source modellen! Met GPT-OSS-120B, zelfs zonder tools, hebben we deze bijna perfecte nauwkeurigheid bereikt terwijl we tot 85% gegenereerde tokens bespaarden.

Het biedt ook veel sterke voordelen voor parallel denken:

🔥 Prestatieverbetering: ~10% nauwkeurigheid over modellen & datasets

⚡ Ultra-efficiënt: Tot 85% minder gegenereerde tokens

🔧 Plug & play: Werkt met ELK bestaand model - geen training nodig (geen hyperparameter tuning ook!)

⭐ Gemakkelijk te implementeren: Slechts ~50 regels code in vLLM (zie PR hieronder)

📚 Paper:

🌐 Project:

gezamenlijk werk met: @FuYichao123 , xuewei_wang, @tydsh

(zie details in de opmerkingen hieronder)

5K

Boven

Positie

Favorieten