トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

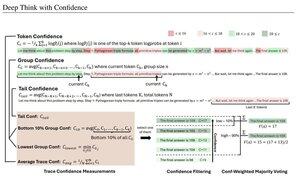

単純な信頼度は、推論トレースをフィルタリングするために使用される平均対数確率に基づいて測定します。繰り返しになりますが、高品質のオープンソースモデルへのアクセスによって可能になった非常に素晴らしい研究です。

悪い結果をプルーニングする「ジェネレータ検証者」アーキテクチャを備えた、より強力なパイプラインを探してください。検証者は、モデルインスタンス、またはこの論文で開発された内部信頼度メトリックのようなある種の数学関数にすることができます。既存のモデルは、この種のパイプラインと大規模なトークン バジェットで使用すると非常に強力です。(ここでは、AIME 2025 に使用される ~1E8 トークンです。

「DeepConfは、モデル内部の信頼度シグナルを活用して、生成中または生成後に低品質の推論トレースを動的にフィルタリングします。追加のモデルトレーニングやハイパーパラメータの調整は必要なく、既存のサービングフレームワークにシームレスに統合できます。DeepConf は、さまざまな推論タスクと、Qwen 3 や GPT-OSS シリーズなどの最新のオープンソース モデルにわたって評価します。特に、AIME 2025 などの困難なベンチマークでは、DeepConf@512 は完全な並列思考と比較して最大 99.9% の精度を達成し、生成されるトークンを最大 84.7% 削減します。」

これらのメタ研究者が OS モデル Qwen、GPT-OSS、DeepSeek を使用しているが、Llama 😢 を使用していないことに注目してください

8月23日 04:00

DeepConf の紹介: 自信を持って深く考える

🚀 オープンソースモデルでAIME 2025で99.9%を達成する最初の方法!ツールがなくてもGPT-OSS-120Bを使用すると、生成されたトークンを最大85%節約しながら、このほぼ完璧な精度に到達しました。

また、並列思考にも多くの強力な利点があります。

🔥 パフォーマンスの向上:モデルとデータセット全体で~10%の精度

⚡ 超効率:生成されるトークンを最大85%削減

🔧 プラグ&プレイ:既存のモデルで動作します-トレーニングは不要です(ハイパーパラメータのチューニングも不要です!

⭐ デプロイが簡単: vLLM のコードはわずか ~50 行です (以下の PR を参照)

📚 紙:

🌐 プロジェクト:

共同研究:@FuYichao123、xuewei_wang、@tydsh

(詳細は以下のコメントをご覧ください)

4.99K

トップ

ランキング

お気に入り