Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

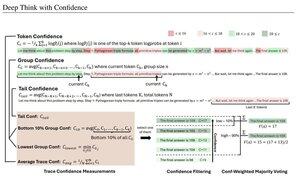

Proste miary pewności oparte na średnim prawdopodobieństwie logarytmicznym używane do filtrowania śladów rozumowania. Jeszcze raz, bardzo fajne badania umożliwione dzięki dostępowi do wysokiej jakości modeli open source.

Szukaj coraz potężniejszych pipeline'ów z architekturą "generator-weryfikator", która przycina złe wyniki. Weryfikator może być instancją modelu lub jakąś funkcją matematyczną, taką jak wewnętrzne metryki pewności opracowane w tym artykule. Istniejące modele są bardzo potężne, gdy są używane z tego rodzaju pipeline'ami i dużymi budżetami tokenów. (Tutaj, ~1E8 tokenów użytych dla AIME 2025.)

"DeepConf wykorzystuje wewnętrzne sygnały pewności modelu do dynamicznego filtrowania niskiej jakości śladów rozumowania podczas lub po generacji. Nie wymaga dodatkowego szkolenia modelu ani dostrajania hiperparametrów i może być płynnie zintegrowany z istniejącymi frameworkami serwisowymi. Oceniamy DeepConf w różnych zadaniach rozumowania oraz na najnowszych modelach open-source, w tym Qwen 3 i serii GPT-OSS. Co ważne, w trudnych benchmarkach, takich jak AIME 2025, DeepConf@512 osiąga do 99,9% dokładności i redukuje generowane tokeny o do 84,7% w porównaniu do pełnego równoległego myślenia."

Zauważ ironię tych badaczy z Meta, którzy używają modeli OS Qwen, GPT-OSS i DeepSeek, ale nie Llama 😢

23 sie, 04:00

Przedstawiamy DeepConf: Głębokie Myślenie z Pewnością

🚀 Pierwsza metoda osiągnięcia 99,9% na AIME 2025 z modelami open-source! Używając GPT-OSS-120B, nawet bez narzędzi, osiągnęliśmy tę niemal doskonałą dokładność, oszczędzając do 85% generowanych tokenów.

Oferuje również wiele silnych zalet dla myślenia równoległego:

🔥 Wzrost wydajności: ~10% dokładności w różnych modelach i zbiorach danych

⚡ Ultraefektywność: Do 85% mniej generowanych tokenów

🔧 Plug & play: Działa z DOWOLNYM istniejącym modelem - zero szkolenia potrzebne (bez dostrajania hiperparametrów!)

⭐ Łatwe wdrożenie: Tylko ~50 linii kodu w vLLM (zobacz PR poniżej)

📚 Artykuł:

🌐 Projekt:

wspólna praca z: @FuYichao123, xuewei_wang, @tydsh

(zobacz szczegóły w komentarzach poniżej)

4,99K

Najlepsze

Ranking

Ulubione