Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

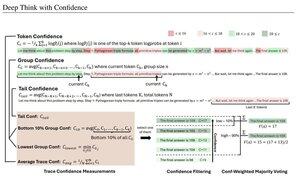

Yksinkertaiset luottamusmittarit perustuvat keskimääräiseen log-todennäköisyyteen, jota käytetään päättelyjälkien suodattamiseen. Jälleen kerran erittäin mukavaa tutkimusta, jonka mahdollistaa pääsy korkealaatuisiin avoimen lähdekoodin malleihin.

Etsi yhä tehokkaampia putkistoja, joissa on "generaattori-todentaja"-arkkitehtuuri, joka karsii huonoja tuloksia. Todentaja voi olla malliinstanssi tai jonkinlainen matemaattinen funktio, kuten tässä artikkelissa kehitetyt sisäiset luottamusmittarit. Nykyiset mallit ovat erittäin tehokkaita, kun niitä käytetään tällaisen putken ja suurten token-budjettien kanssa. (Tässä ~1E8 tokenia, joita käytetään AIME 2025:ssä.)

"DeepConf hyödyntää mallin sisäisiä luottamussignaaleja suodattaakseen dynaamisesti huonolaatuisia päättelyjälkiä sukupolven aikana tai sen jälkeen. Se ei vaadi ylimääräistä mallikoulutusta tai hyperparametrien viritystä, ja se voidaan integroida saumattomasti olemassa oleviin tarjoilukehyksiin. Arvioimme DeepConfia erilaisissa päättelytehtävissä ja uusimmissa avoimen lähdekoodin malleissa, mukaan lukien Qwen 3- ja GPT-OSS-sarjat. Erityisesti haastavissa vertailuarvoissa, kuten AIME 2025, DeepConf@512 saavuttaa jopa 99,9 %:n tarkkuuden ja vähentää luotuja tokeneita jopa 84,7 % verrattuna täysin rinnakkaiseen ajatteluun."

Huomaa ironiaa, että nämä Meta-tutkijat käyttävät käyttöjärjestelmämalleja Qwen, GPT-OSS ja DeepSeek, mutta ei laamaa 😢

23.8. klo 04.00

Esittelyssä DeepConf: Deep Think with Confidence

🚀 Ensimmäinen tapa saavuttaa 99.9 % AIME 2025:ssä avoimen lähdekoodin malleilla! Käyttämällä GPT-OSS-120B:tä jopa ilman työkaluja saavutimme tämän lähes täydellisen tarkkuuden ja säästimme jopa 85 % luoduista tokeneista.

Se tarjoaa myös monia vahvoja etuja rinnakkaisajatteluun:

🔥 Suorituskyvyn parannus: ~10 %:n tarkkuus malleissa ja tietojoukoissa

⚡ Erittäin tehokas: Jopa 85 % vähemmän tokeneita

🔧 Plug & play: Toimii MINKÄ tahansa olemassa olevan mallin kanssa - koulutusta ei tarvita (ei myöskään hyperparametrien viritystä!)

⭐ Helppo ottaa käyttöön: Vain ~50 riviä koodia vLLM:ssä (katso PR alla)

📚 Paperi:

🌐 Projekti:

Yhteistyö: @FuYichao123 , xuewei_wang, @tydsh

(katso yksityiskohdat alla olevista kommenteista)

5,07K

Johtavat

Rankkaus

Suosikit