Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

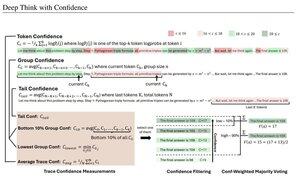

Misure di fiducia semplici basate sulla probabilità logaritmica media utilizzate per filtrare le tracce di ragionamento. Ancora una volta, una ricerca molto interessante abilitata dall'accesso a modelli open source di alta qualità.

Cerca pipeline sempre più potenti con architettura "generatore-verificatore" che elimina i risultati scadenti. Il verificatore può essere un'istanza del modello, o qualche tipo di funzione matematica come le metriche di fiducia interne sviluppate in questo documento. I modelli esistenti sono molto potenti quando utilizzati con questo tipo di pipeline e grandi budget di token. (Qui, ~1E8 token utilizzati per AIME 2025.)

"DeepConf sfrutta i segnali di fiducia interni del modello per filtrare dinamicamente le tracce di ragionamento di bassa qualità durante o dopo la generazione. Non richiede ulteriori addestramenti del modello o ottimizzazione degli iperparametri e può essere integrato senza problemi nei framework di servizio esistenti. Valutiamo DeepConf su una varietà di compiti di ragionamento e sui più recenti modelli open-source, inclusi Qwen 3 e la serie GPT-OSS. Notabilmente, su benchmark impegnativi come AIME 2025, DeepConf@512 raggiunge fino al 99,9% di accuratezza e riduce i token generati fino all'84,7% rispetto al pensiero parallelo completo."

Nota l'ironia di questi ricercatori di Meta che utilizzano modelli OS Qwen, GPT-OSS e DeepSeek, ma non Llama 😢

23 ago, 04:00

Introducendo DeepConf: Pensa in Profondità con Fiducia

🚀 Primo metodo per raggiungere il 99,9% su AIME 2025 con modelli open-source! Utilizzando GPT-OSS-120B anche senza strumenti, abbiamo raggiunto questa precisione quasi perfetta risparmiando fino all'85% dei token generati.

Offre anche molti forti vantaggi per il pensiero parallelo:

🔥 Aumento delle prestazioni: ~10% di precisione su modelli e dataset

⚡ Ultra-efficiente: Fino all'85% in meno di token generati

🔧 Plug & play: Funziona con QUALSIASI modello esistente - nessun addestramento necessario (niente ottimizzazione degli iperparametri!)

⭐ Facile da implementare: Solo ~50 righe di codice in vLLM (vedi PR qui sotto)

📚 Documento:

🌐 Progetto:

lavoro congiunto con: @FuYichao123 , xuewei_wang, @tydsh

(vedi dettagli nei commenti qui sotto)

5K

Principali

Ranking

Preferiti