Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

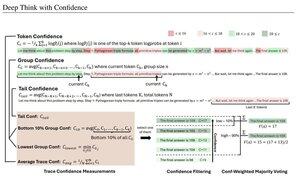

Einfache Vertrauensmaße basierend auf der durchschnittlichen Log-Wahrscheinlichkeit, die verwendet werden, um Denkspuren zu filtern. Nochmals, sehr schöne Forschung, ermöglicht durch den Zugang zu hochwertigen Open-Source-Modellen.

Achten Sie auf immer leistungsfähigere Pipelines mit "Generator-Verifier"-Architektur, die schlechte Ergebnisse aussondert. Der Verifier kann eine Modellinstanz oder eine Art mathematische Funktion sein, wie die internen Vertrauensmetriken, die in diesem Papier entwickelt wurden. Bestehende Modelle sind sehr leistungsfähig, wenn sie mit dieser Art von Pipeline und großen Token-Budgets verwendet werden. (Hier wurden ~1E8 Tokens für AIME 2025 verwendet.)

"DeepConf nutzt interne Vertrauenssignale des Modells, um während oder nach der Generierung dynamisch qualitativ minderwertige Denkspuren herauszufiltern. Es erfordert kein zusätzliches Modelltraining oder Hyperparameter-Tuning und kann nahtlos in bestehende Bereitstellungsframeworks integriert werden. Wir bewerten DeepConf über eine Vielzahl von Denkaufgaben und die neuesten Open-Source-Modelle, einschließlich Qwen 3 und der GPT-OSS-Serie. Bemerkenswerterweise erreicht DeepConf@512 bei herausfordernden Benchmarks wie AIME 2025 eine Genauigkeit von bis zu 99,9 % und reduziert die generierten Tokens um bis zu 84,7 % im Vergleich zum vollständigen parallelen Denken."

Beachten Sie die Ironie dieser Meta-Forscher, die OS-Modelle wie Qwen, GPT-OSS und DeepSeek verwenden, aber kein Llama 😢

23. Aug., 04:00

Einführung von DeepConf: Tiefes Denken mit Vertrauen

🚀 Erste Methode, um 99,9 % bei AIME 2025 mit Open-Source-Modellen zu erreichen! Mit GPT-OSS-120B haben wir sogar ohne Werkzeuge diese nahezu perfekte Genauigkeit erreicht und dabei bis zu 85 % der generierten Tokens eingespart.

Es bietet auch viele starke Vorteile für paralleles Denken:

🔥 Leistungssteigerung: ~10 % Genauigkeit über Modelle & Datensätze

⚡ Ultra-effizient: Bis zu 85 % weniger generierte Tokens

🔧 Plug & Play: Funktioniert mit JEDEM bestehenden Modell - keine Schulung erforderlich (auch kein Hyperparameter-Tuning!)

⭐ Einfach zu implementieren: Nur ~50 Zeilen Code in vLLM (siehe PR unten)

📚 Papier:

🌐 Projekt:

gemeinsame Arbeit mit: @FuYichao123 , xuewei_wang, @tydsh

(siehe Details in den Kommentaren unten)

5K

Top

Ranking

Favoriten