Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

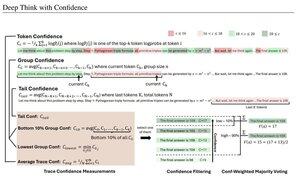

Enkle konfidensmål basert på gjennomsnittlig loggsannsynlighet som brukes til å filtrere resonneringsspor. Nok en gang, veldig fin forskning muliggjort av tilgang til åpen kildekode-modeller av høy kvalitet.

Se etter kraftigere og kraftigere rørledninger med "generator-verifikator"-arkitektur som beskjærer dårlige resultater. Verifikatoren kan være en modellforekomst, eller en slags matematisk funksjon som de interne konfidensmålingene utviklet i denne artikkelen. Eksisterende modeller er svært kraftige når de brukes med denne typen pipeline og store tokenbudsjetter. (Her brukes ~1E8-tokens for AIME 2025.)

"DeepConf utnytter modellens interne konfidenssignaler for dynamisk å filtrere ut resonnementspor av lav kvalitet under eller etter generering. Den krever ingen ekstra modellopplæring eller justering av hyperparametere og kan integreres sømløst i eksisterende serveringsrammeverk. Vi evaluerer DeepConf på tvers av en rekke resonneringsoppgaver og de nyeste åpen kildekode-modellene, inkludert Qwen 3 og GPT-OSS-serien. Spesielt, på utfordrende benchmarks som AIME 2025, oppnår DeepConf@512 opptil 99,9 % nøyaktighet og reduserer genererte tokens med opptil 84,7 % sammenlignet med full parallell tenkning.»

Legg merke til ironien i at disse Meta-forskerne bruker OS-modellene Qwen, GPT-OSS og DeepSeek, men ingen lama 😢

23. aug., 04:00

Vi introduserer DeepConf: Tenk dypt med selvtillit

🚀 Første metode for å oppnå 99.9 % på AIME 2025 med åpen kildekode-modeller! Ved å bruke GPT-OSS-120B selv uten verktøy, nådde vi denne nesten perfekte nøyaktigheten samtidig som vi sparte opptil 85 % genererte tokens.

Det gir også mange sterke fordeler for parallell tenkning:

🔥 Ytelsesøkning: ~10 % nøyaktighet på tvers av modeller og datasett

⚡ Ultraeffektiv: Opptil 85 % færre tokens generert

🔧 Plug & play: Fungerer med ALLE eksisterende modeller - null trening nødvendig (ingen hyperparameterjustering også!)

⭐ Enkel å distribuere: Bare ~50 linjer med kode i vLLM (se PR nedenfor)

📚 Papir:

🌐 Prosjekt:

Felles arbeid med: @FuYichao123, xuewei_wang, @tydsh

(se detaljer i kommentarene nedenfor)

4,99K

Topp

Rangering

Favoritter