المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

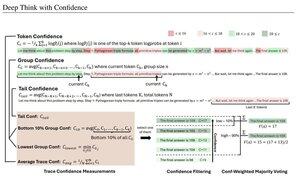

مقاييس الثقة البسيطة تستند إلى متوسط احتمالية السجل المستخدمة لتصفية آثار التفكير. مرة أخرى ، تم تمكين البحث الجميل للغاية من خلال الوصول إلى نماذج مفتوحة المصدر عالية الجودة.

ابحث عن المزيد والمزيد من خطوط الأنابيب القوية مع بنية "التحقق من المولد" التي تقليم النتائج السيئة. يمكن أن يكون المدقق مثيلا نموذجيا ، أو نوعا من الوظائف الرياضية مثل مقاييس الثقة الداخلية التي تم تطويرها في هذه الورقة. النماذج الحالية قوية جدا عند استخدامها مع هذا النوع من خطوط الأنابيب وميزانيات الرموز الكبيرة. (هنا ، ~ 1E8 tokens المستخدمة ل AIME 2025.)

"تستفيد DeepConf من إشارات الثقة الداخلية للنموذج لتصفية آثار التفكير منخفضة الجودة ديناميكيا أثناء التوليد أو بعده. لا يتطلب أي تدريب إضافي على النموذج أو ضبط المعلمات الفائقة ويمكن دمجه بسلاسة في أطر الخدمة الحالية. نقوم بتقييم DeepConf عبر مجموعة متنوعة من مهام التفكير وأحدث النماذج مفتوحة المصدر ، بما في ذلك سلسلة Qwen 3 و GPT-OSS. والجدير بالذكر أنه في المعايير الصعبة مثل AIME 2025 ، يحقق DeepConf@512 دقة تصل إلى 99.9٪ ويقلل من الرموز المميزة التي تم إنشاؤها بنسبة تصل إلى 84.7٪ مقارنة بالتفكير الموازي الكامل ".

لاحظ المفارقة في أن باحثي Meta هؤلاء يستخدمون نماذج نظام التشغيل Quwen و GPT-OSS و DeepSeek ، ولكن لا يوجد Llama 😢

23 أغسطس، 04:00

تقديم DeepConf: التفكير العميق بثقة

🚀 الطريقة الأولى لتحقيق 99.9٪ في AIME 2025 مع نماذج مفتوحة المصدر! باستخدام GPT-OSS-120B حتى بدون أدوات ، وصلنا إلى هذه الدقة شبه المثالية مع توفير ما يصل إلى 85٪ من الرموز المميزة التي تم إنشاؤها.

كما أنه يوفر العديد من المزايا القوية للتفكير الموازي:

🔥 تعزيز الأداء: ~ 10٪ دقة عبر النماذج ومجموعات البيانات

⚡ كفاءة فائقة: تم إنشاء ما يصل إلى 85٪ أقل من الرموز المميزة

🔧 التوصيل والتشغيل: يعمل مع أي نموذج موجود - لا حاجة للتدريب (لا يوجد ضبط المعلمات الفائقة أيضا!)

⭐ سهل النشر: فقط ~ 50 سطرا من التعليمات البرمجية في vLLM (انظر العلاقات العامة أدناه)

📚 ورق:

🌐 مشروع:

العمل المشترك مع: @FuYichao123 ، xuewei_wang ، @tydsh

(انظر التفاصيل في التعليقات أدناه)

5.08K

الأفضل

المُتصدِّرة

التطبيقات المفضلة