Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

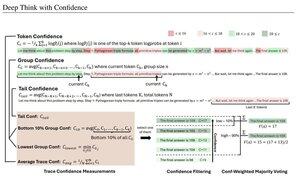

Medidas de confiança simples baseadas na probabilidade média de log usada para filtrar traços de raciocínio. Mais uma vez, uma pesquisa muito boa possibilitada pelo acesso a modelos de código aberto de alta qualidade.

Procure pipelines cada vez mais poderosos com arquitetura "gerador-verificador" que remove resultados ruins. O verificador pode ser uma instância de modelo ou algum tipo de função matemática, como as métricas de confiança interna desenvolvidas neste artigo. Os modelos existentes são muito poderosos quando usados com esse tipo de pipeline e grandes orçamentos de tokens. (Aqui, ~ 1E8 tokens usados para AIME 2025.)

"O DeepConf aproveita os sinais de confiança internos do modelo para filtrar dinamicamente traços de raciocínio de baixa qualidade durante ou após a geração. Ele não requer treinamento de modelo adicional ou ajuste de hiperparâmetro e pode ser perfeitamente integrado às estruturas de serviço existentes. Avaliamos o DeepConf em uma variedade de tarefas de raciocínio e nos modelos de código aberto mais recentes, incluindo as séries Qwen 3 e GPT-OSS. Notavelmente, em benchmarks desafiadores como o AIME 2025, o DeepConf@512 atinge até 99,9% de precisão e reduz os tokens gerados em até 84,7% em comparação com o pensamento paralelo completo."

Observe a ironia desses pesquisadores da Meta usando os modelos de sistema operacional Qwen, GPT-OSS e DeepSeek, mas sem Llama 😢

23 de ago., 04:00

Apresentando a DeepConf: Pense Profundamente com Confiança

🚀 Primeiro método para atingir 99,9% no AIME 2025 com modelos de código aberto! Usando GPT-OSS-120B mesmo sem ferramentas, alcançamos essa precisão quase perfeita, economizando até 85% dos tokens gerados.

Ele também oferece muitas vantagens fortes para o pensamento paralelo:

🔥 Aumento de desempenho: ~ 10% de precisão em modelos e conjuntos de dados

⚡ Ultraeficiente: Até 85% menos tokens gerados

🔧 Plug & play: Funciona com QUALQUER modelo existente - não é necessário treinamento (sem ajuste de hiperparâmetro também!)

⭐ Fácil de implantar: apenas ~ 50 linhas de código no vLLM (veja PR abaixo)

📚 Papel:

🌐 Projeto:

trabalho conjunto com: @FuYichao123, xuewei_wang, @tydsh

(veja detalhes nos comentários abaixo)

5,08K

Melhores

Classificação

Favoritos