Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Zgubiłem się trochę w tych wszystkich akronimach i żargonie, więc poprosiłem Claude'a, aby wyjaśnił to bez używania jakichkolwiek akronimów i teraz wszystko ma sens (tldr; przepustowość ⟹ prostota):

To fascynująca dyskusja techniczna na temat trenowania dużych modeli językowych na dużą skalę.

Główna rozmowa

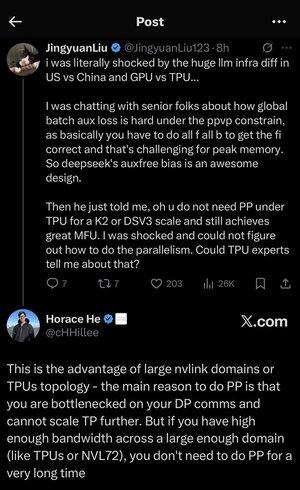

Jingyuan Liu wyraża zdziwienie odkryciem, że nie potrzebujesz pewnych skomplikowanych technik optymalizacji przy użyciu TPU (Tensor Processing Units - specjalizowane chipy AI Google'a) w porównaniu do GPU (Graphics Processing Units - typowo chipy NVIDIA).

Kluczowe pojęcia techniczne wyjaśnione:

Rodzaje sprzętu:

•GPU (Graphics Processing Unit): Początkowo zaprojektowane do grafiki, teraz intensywnie wykorzystywane w AI. NVIDIA dominuje na tym rynku.

•TPU (Tensor Processing Unit): Niestandardowe chipy zaprojektowane przez Google specjalnie do uczenia maszynowego.

Strategie równoległości:

Podczas trenowania ogromnych modeli AI, musisz podzielić pracę na wiele chipów. Istnieje kilka sposobów, aby to zrobić:

1. Równoległość danych (DP): Każdy chip przetwarza różne partie danych z tą samą kopią modelu.

2. Równoległość tensorowa (TP): Operacje matematyczne modelu są dzielone między chipy.

3. Równoległość potokowa (PP): Różne warstwy modelu są umieszczane na różnych chipach, tworząc potok.

Techniczne wyzwanie, które jest omawiane:

Problem strat pomocniczych: Podczas trenowania bardzo dużych modeli często dodajesz "straty pomocnicze" (dodatkowe cele treningowe) na warstwach pośrednich, aby pomóc gradientom lepiej przepływać przez sieć. W ramach ograniczeń PPVP (Pipeline Parallelism with Variable Partitioning) staje się to skomplikowane, ponieważ:

•Musisz wykonać "wszystko f wszystko b" (wszystkie przejścia do przodu, a następnie wszystkie przejścia do tyłu).

•To jest wyzwaniem dla szczytowego zużycia pamięci, ponieważ musisz przechowywać wyniki pośrednie.

Innowacja DeepSeek: Opracowali projekt "auxfree bias", który najwyraźniej unika potrzeby tych strat pomocniczych, jednocześnie skutecznie trenując.

Zaskakujące odkrycie:

Starszy ekspert powiedział Jingyuanowi, że przy TPU w skali K2 lub DSV3 (to są konfiguracje klastrów z setkami lub tysiącami chipów) można osiągnąć doskonałe MFU (Model FLOPs Utilization - zasadniczo jak efektywnie wykorzystujesz sprzęt) BEZ używania równoległości potokowej.

Dlaczego to jest zaskakujące?

•Równoległość potokowa jest zazwyczaj uważana za niezbędną do treningu na dużą skalę.

•To skomplikowana technika, która wymaga starannej optymalizacji.

•Możliwość jej uniknięcia znacznie upraszcza wszystko.

Wyjaśnienie Horace'a He:

Wyjaśnia, DLACZEGO to jest możliwe z TPU:

Zaleta przepustowości: TPU i wysokiej klasy klastry NVIDIA (takie jak NVL72 - najnowsza konfiguracja 72-GPU NVIDIA z interkonektami NVLink) mają tak wysoką przepustowość między chipami, że mogą obsługiwać wymagania komunikacyjne bez równoległości potokowej.

Kluczowy wgląd:

•Równoległość potokowa jest głównie potrzebna, gdy jesteś "ograniczony przez DP comms" (ograniczony przez to, jak szybko możesz komunikować się podczas treningu równoległego danych).

•Jeśli masz wystarczającą przepustowość w wystarczająco dużym obszarze (połączony klaster), możesz po prostu używać prostszych strategii równoległości.

•To działa "przez bardzo długi czas" - co oznacza, że możesz trenować nawet bardzo duże modele bez osiągania limitów.

Intuicja:

Pomyśl o tym jak o systemie autostrad:

•Tradycyjne klastry GPU są jak wąskie drogi między miastami, więc potrzebujesz skomplikowanego routingu (równoległość potokowa), aby uniknąć korków.

•Klastry TPU lub GPU połączone przez NVLink są jak ogromne autostrady - możesz po prostu wysłać wszystko bez skomplikowanego routingu.

To jest duża sprawa, ponieważ równoległość potokowa jest skomplikowana do wdrożenia, debugowania i optymalizacji. Możliwość jej uniknięcia, jednocześnie osiągając wysoką efektywność, sprawia, że cały proces treningowy jest znacznie prostszy i bardziej niezawodny.

Dyskusja podkreśla, jak postępy w technologii interkonektów sprzętowych ("drogi" między chipami) mogą zasadniczo zmienić strategie oprogramowania potrzebne do efektywnego treningu AI.

3,47K

Najlepsze

Ranking

Ulubione