Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

M-am pierdut puțin în toate acronimele și jargonul de aici, așa că l-am pus pe Claude să explice fără a folosi acronime și acum totul are sens (tldr; lățime de bandă ⟹ simplitate):

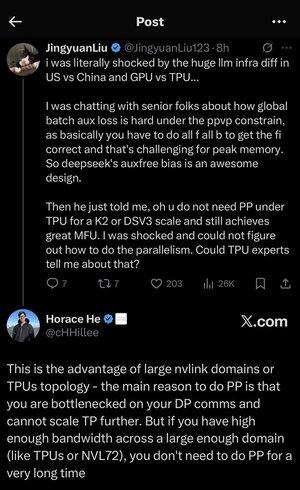

Aceasta este o discuție tehnică fascinantă despre antrenarea modelelor lingvistice mari la scară.

Conversația de bază

Jingyuan Liu își exprimă surprinderea când descoperă că nu aveți nevoie de anumite tehnici complexe de optimizare atunci când utilizați TPU-uri (Tensor Processing Units - cipurile AI specializate de Google) versus GPU-uri (Graphics Processing Units - de obicei cipurile NVIDIA).

Concepte tehnice cheie explicate:

Tipuri hardware:

• GPU (Graphics Processing Unit): Proiectat inițial pentru grafică, acum utilizat intens pentru AI. NVIDIA domină această piață.

• TPU (Tensor Processing Unit): cipurile personalizate de la Google special pentru învățarea automată.

Strategii de paralelism:

Când antrenați modele masive de inteligență artificială, trebuie să împărțiți munca între mai multe cipuri. Există mai multe moduri de a face acest lucru:

1Paralelism de date (DP): Fiecare cip procesează loturi diferite de date cu aceeași copie a modelului

2Paralelismul tensorial (TP): Operațiile matematice ale modelului sunt împărțite între cipuri

3Paralelismul conductei (PP): Diferite straturi ale modelului sunt plasate pe cipuri diferite, creând o conductă

Provocarea tehnică discutată:

Problema pierderilor auxiliare: Când antrenați modele foarte mari, adăugați adesea "pierderi auxiliare" (obiective de antrenament suplimentare) la straturile intermediare pentru a ajuta gradientele să curgă mai bine prin rețea. În cadrul constrângerilor PPVP (Pipeline Parallelism with Variable Partitioning), acest lucru devine complex deoarece:

•Trebuie să faceți "toate toate pasele b" (toate pasele înainte, apoi toate pasele înapoi)

•Acest lucru este o provocare pentru utilizarea maximă a memoriei, deoarece trebuie să stocați rezultate intermediare

Inovația DeepSeek: Au dezvoltat un design "auxfree bias" care aparent evită să aibă nevoie de aceste pierderi auxiliare în timp ce se antrenează eficient.

Revelația surprinzătoare:

Expertul senior i-a spus lui Jingyuan că cu TPU-uri la scară K2 sau DSV3 (acestea sunt configurații de cluster cu sute sau mii de cipuri), puteți obține MFU (Model FLOPs Utilization - practic cât de eficient utilizați hardware-ul) FĂRĂ a utiliza Pipeline Parallelism.

De ce este surprinzător?

•Paralelismul conductelor este de obicei considerat esențial pentru instruirea la scară largă

• Este o tehnică complexă care necesită o optimizare atentă

• Posibilitatea de a-l evita simplifică totul semnificativ

Explicația lui Horace He:

El explică de ce acest lucru este posibil cu TPU-urile:

Avantajul lățimii de bandă: TPU-urile și clusterele NVIDIA de ultimă generație (cum ar fi NVL72 - cea mai recentă configurație NVIDIA cu 72 de GPU-uri cu interconexiuni NVLink) au o lățime de bandă atât de mare între cipuri încât pot face față cerințelor de comunicare fără paralelism de conductă.

Ideea cheie:

• Paralelismul conductei este necesar în primul rând atunci când sunteți "blocat în comunicațiile DP" (limitat de cât de repede puteți comunica în timpul antrenamentului paralel al datelor)

•Dacă aveți suficientă lățime de bandă într-un domeniu suficient de mare (cluster interconectat), puteți utiliza strategii de paralelism mai simple

• Acest lucru funcționează "pentru o perioadă foarte lungă de timp" - ceea ce înseamnă că puteți antrena chiar și modele foarte mari fără a atinge limitele

Intuiția:

Gândiți-vă la asta ca la un sistem de autostrăzi:

• Clusterele GPU tradiționale sunt ca și cum ai avea drumuri înguste între orașe, așa că ai nevoie de rutare complexă (Pipeline Parallelism) pentru a evita ambuteiajele

• Clusterele TPU sau GPU-urile conectate NVLink sunt ca și cum ai avea autostrăzi masive - poți trimite totul direct fără rutare fantezistă

Aceasta este o mare problemă, deoarece paralelismul conductei este complex de implementat, depanat și optimizat. Posibilitatea de a o evita în timp ce obține o eficiență ridicată face ca întregul proces de instruire să fie mult mai simplu și mai fiabil.

Discuția evidențiază modul în care progresele în tehnologia de interconectare hardware ("drumurile" dintre cipuri) pot schimba fundamental strategiile software necesare pentru un antrenament eficient AI.

3,48K

Limită superioară

Clasament

Favorite