热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

我在这里的所有缩略语和行话中有点迷失,所以我让Claude不使用任何缩略语来解释,现在一切都变得非常清晰(简而言之;带宽 ⟹ 简单性):

这是关于大规模训练大型语言模型的一个引人入胜的技术讨论。

核心对话

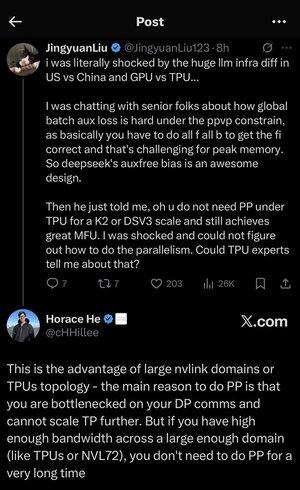

Jingyuan Liu 对发现使用TPU(张量处理单元 - 谷歌的专用AI芯片)与GPU(图形处理单元 - 通常是NVIDIA的芯片)时不需要某些复杂的优化技术感到惊讶。

关键技术概念解释:

硬件类型:

• GPU(图形处理单元):最初设计用于图形,现在广泛用于AI。NVIDIA主导这个市场。

• TPU(张量处理单元):谷歌专为机器学习设计的定制芯片。

并行策略:

在训练大型AI模型时,您需要将工作分配到多个芯片上。有几种方法可以做到这一点:

1 数据并行(DP):每个芯片处理不同批次的数据,使用相同的模型副本

2 张量并行(TP):模型的数学运算分布在多个芯片上

3 流水线并行(PP):模型的不同层放置在不同的芯片上,形成一个流水线

正在讨论的技术挑战:

辅助损失问题:在训练非常大的模型时,您通常会在中间层添加“辅助损失”(额外的训练目标),以帮助梯度更好地流动通过网络。在PPVP(具有可变分区的流水线并行)约束下,这变得复杂,因为:

• 您需要进行“所有前向传递,然后所有反向传递”

• 这对峰值内存使用是一个挑战,因为您必须存储中间结果

DeepSeek的创新:他们开发了一种“无辅助偏差”设计,显然避免了在仍然有效训练的情况下需要这些辅助损失。

令人惊讶的发现:

高级专家告诉Jingyuan,在K2或DSV3规模的TPU(这些是具有数百或数千个芯片的集群配置)下,您可以在不使用流水线并行的情况下实现出色的MFU(模型FLOPs利用率 - 基本上是您使用硬件的效率)。

为什么这令人惊讶?

• 流水线并行通常被认为是大规模训练的必要条件

• 这是一种复杂的技术,需要仔细优化

• 能够避免它显著简化了一切

Horace He的解释:

他解释了为什么这在TPU上是可能的:

带宽优势:TPU和高端NVIDIA集群(如NVL72 - NVIDIA最新的72-GPU配置,带有NVLink互连)之间的带宽如此之高,以至于它们可以在没有流水线并行的情况下处理通信需求。

关键见解:

• 当您在“DP通信上瓶颈”时(在数据并行训练期间的通信速度受限),流水线并行主要是必需的

• 如果您在一个足够大的领域(互连集群)中有足够的带宽,您可以使用更简单的并行策略

• 这可以“持续很长时间” - 意味着您可以在不达到限制的情况下训练非常大的模型

直觉:

把它想象成一个高速公路系统:

• 传统的GPU集群就像城市之间有狭窄的道路,因此您需要复杂的路由(流水线并行)来避免交通堵塞

• TPU集群或NVLink连接的GPU就像有巨大的超级高速公路 - 您可以直接发送所有内容,而无需复杂的路由

这很重要,因为流水线并行的实现、调试和优化都很复杂。能够在仍然实现高效率的情况下避免它,使整个训练过程变得更简单、更可靠。

讨论强调了硬件互连技术的进步(芯片之间的“道路”)如何从根本上改变高效AI训练所需的软件策略。

3.46K

热门

排行

收藏