Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La maggior parte delle valutazioni AI sono costose bugie.

Di solito misurano ciò che è facile da misurare—metriche come "allucinazione" e "tossicità"—non i modi specifici in cui il tuo prodotto fallisce realmente per gli utenti.

@HamelHusain e @sh_reya insegnano un approccio diverso—uno che ha reso il loro corso il #1 per incassi su @MavenHQ, con iscrizioni costanti da @OpenAI, @AnthropicAI e ogni grande laboratorio di AI.

La loro intuizione: Inizia con l'analisi degli errori, non con le metriche.

Esamina 100 interazioni reali con gli utenti. Scrivi critiche dettagliate su cosa è andato realmente storto. Trova schemi. Solo allora costruisci valutazioni che migliorano il tuo prodotto.

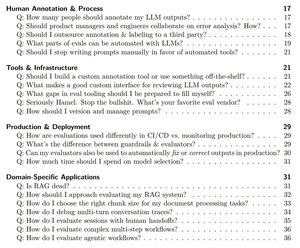

Dopo aver formato oltre 2.000 PM e ingegneri in più di 500 aziende, hanno distillato la loro metodologia in un manuale sistematico che ti mostra esattamente come:

- Identificare i ~10 modi di fallimento che rompono realmente il tuo prodotto

- Costruire giudici LLM che puoi convalidare statisticamente e di cui puoi fidarti

- Creare pipeline CI/CD che catturano le regressioni prima che lo facciano gli utenti

- Trasformare il monitoraggio della produzione in un motore di scoperta per nuovi problemi

Leggi la loro guida completa qui:

Principali

Ranking

Preferiti