Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Większość ocen AI to drogie kłamstwa.

Zazwyczaj mierzą to, co łatwo zmierzyć—metryki takie jak "halucynacje" i "toksyczność"—a nie konkretne sposoby, w jakie Twój produkt faktycznie zawodzi użytkowników.

@HamelHusain i @sh_reya uczą innego podejścia—takiego, które uczyniło ich kurs numerem 1 pod względem przychodów na @MavenHQ, z ciągłym zapisami od @OpenAI, @AnthropicAI i każdego większego laboratorium AI.

Ich spostrzeżenie: Zacznij od analizy błędów, a nie metryk.

Przejrzyj 100 rzeczywistych interakcji z użytkownikami. Napisz szczegółowe krytyki tego, co faktycznie poszło źle. Znajdź wzorce. Dopiero wtedy buduj oceny, które poprawią Twój produkt.

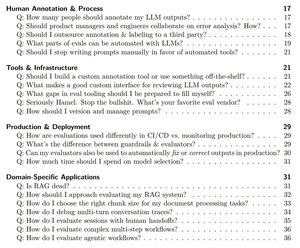

Po przeszkoleniu ponad 2000 PM-ów i inżynierów w ponad 500 firmach, zdestylowali swoją metodologię w systematyczny podręcznik, który pokazuje dokładnie, jak:

- Zidentyfikować ~10 trybów awarii, które faktycznie psują Twój produkt

- Zbudować sędziów LLM, których możesz statystycznie zweryfikować i którym możesz zaufać

- Stworzyć pipeline CI/CD, które wychwytują regresje zanim zrobią to użytkownicy

- Przekształcić monitorowanie produkcji w silnik odkryć nowych problemów

Przeczytaj ich kompletny przewodnik tutaj:

Najlepsze

Ranking

Ulubione