Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Die meisten KI-Evaluierungen sind teure Lügen.

Sie messen normalerweise, was leicht zu messen ist – Metriken wie "Halluzination" und "Toxizität" – nicht die spezifischen Wege, wie Ihr Produkt tatsächlich den Nutzern schadet.

@HamelHusain und @sh_reya lehren einen anderen Ansatz – einen, der ihren Kurs zum #1 umsatzstärksten auf @MavenHQ gemacht hat, mit konstanten Einschreibungen von @OpenAI, @AnthropicAI und jedem großen KI-Labor.

Ihr Einblick: Beginnen Sie mit der Fehleranalyse, nicht mit Metriken.

Überprüfen Sie 100 echte Nutzerinteraktionen. Schreiben Sie detaillierte Kritiken darüber, was tatsächlich schiefgelaufen ist. Finden Sie Muster. Nur dann bauen Sie Evaluierungen, die Ihr Produkt verbessern.

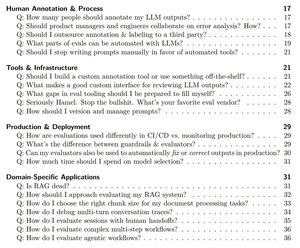

Nach der Schulung von über 2.000 PMs und Ingenieuren in mehr als 500 Unternehmen haben sie ihre Methodik in ein systematisches Handbuch destilliert, das Ihnen genau zeigt, wie Sie:

- Die ~10 Fehlermodi identifizieren, die Ihr Produkt tatsächlich kaputt machen

- LLM-Richter erstellen, die Sie statistisch validieren und denen Sie vertrauen können

- CI/CD-Pipelines erstellen, die Regressionen abfangen, bevor es die Nutzer tun

- Die Produktionsüberwachung in eine Entdeckungsmaschine für neue Probleme verwandeln

Lesen Sie hier ihren vollständigen Leitfaden:

Top

Ranking

Favoriten