Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A maioria das avaliações de IA são mentiras caras.

Eles geralmente medem o que é fácil de medir – métricas como "alucinação" e "toxicidade" – e não as maneiras específicas pelas quais seu produto realmente falha com os usuários.

@HamelHusain e @sh_reya ensinam uma abordagem diferente - que tornou seu curso o # 1 de maior bilheteria em @MavenHQ, com matrículas consistentes de @OpenAI, @AnthropicAI e todos os principais laboratórios de IA.

Seu insight: comece com a análise de erros, não com métricas.

Revise 100 interações reais do usuário. Escreva críticas detalhadas sobre o que realmente deu errado. Encontre padrões. Só então construa avaliações que tornem seu produto melhor.

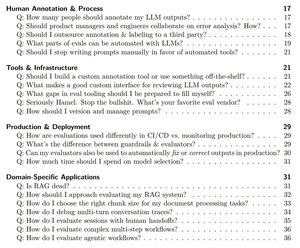

Depois de treinar 2.000+ PMs e engenheiros em 500+ empresas, eles destilaram sua metodologia em um manual sistemático que mostra exatamente como:

- Identifique os ~10 modos de falha que realmente quebram seu produto

- Crie juízes LLM que você possa validar e confiar estatisticamente

- Crie pipelines de CI/CD que capturam regressões antes que os usuários o façam

- Transforme o monitoramento da produção em um mecanismo de descoberta para novos problemas

Leia o guia completo aqui:

Melhores

Classificação

Favoritos