Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Majoritatea evaluărilor AI sunt minciuni scumpe.

De obicei, măsoară ceea ce este ușor de măsurat – valori precum "halucinații" și "toxicitate" – nu modurile specifice în care produsul tău eșuează de fapt utilizatorii.

@HamelHusain și @sh_reya predau o abordare diferită - una care a făcut ca cursul lor să fie #1 cu cele mai mari încasări la @MavenHQ, cu înscrieri consistente de la @OpenAI, @AnthropicAI și fiecare laborator major de inteligență artificială.

Ideea lor: Începeți cu analiza erorilor, nu cu valorile.

Revizuiți 100 de interacțiuni reale ale utilizatorilor. Scrieți critici detaliate despre ceea ce a mers prost de fapt. Găsiți modele. Abia apoi construiți evaluări care vă îmbunătățesc produsul.

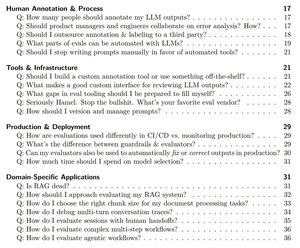

După ce au instruit 2.000+ PM și ingineri la 500+ companii, și-au distilat metodologia într-un manual sistematic care vă arată exact cum:

- Identificați ~10 moduri de eșec care vă sparg de fapt produsul

- Construiți judecători LLM pe care îi puteți valida statistic și în care puteți avea încredere

- Creați conducte CI/CD care prind regresiile înainte ca utilizatorii să o facă

- Transformați monitorizarea producției într-un motor de descoperire a noilor probleme

Citiți ghidul lor complet aici:

Limită superioară

Clasament

Favorite