Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Большинство оценок ИИ — это дорогие обманщики.

Они обычно измеряют то, что легко измерить — такие метрики, как "галлюцинации" и "токсичность" — а не конкретные способы, которыми ваш продукт на самом деле не удовлетворяет пользователей.

@HamelHusain и @sh_reya обучают другому подходу — тому, который сделал их курс самым прибыльным на @MavenHQ, с постоянным набором студентов из @OpenAI, @AnthropicAI и каждой крупной лаборатории ИИ.

Их идея: Начните с анализа ошибок, а не с метрик.

Просмотрите 100 реальных взаимодействий с пользователями. Напишите подробные критические замечания о том, что на самом деле пошло не так. Найдите закономерности. Только после этого создавайте оценки, которые улучшат ваш продукт.

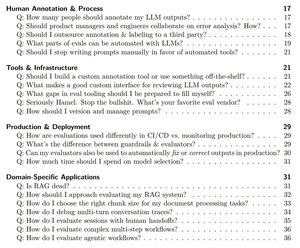

После обучения более 2000 менеджеров по продуктам и инженеров в более чем 500 компаниях они свели свою методологию в систематическую книгу, которая показывает вам, как:

- Определить ~10 режимов отказа, которые на самом деле ломают ваш продукт

- Создать судей LLM, которых вы можете статистически проверить и которым можно доверять

- Создать CI/CD пайплайны, которые ловят регрессии до того, как это сделают пользователи

- Превратить мониторинг производства в двигатель открытия новых проблем

Прочитайте их полное руководство здесь:

Топ

Рейтинг

Избранное