Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

De meeste AI-evaluaties zijn dure leugens.

Ze meten meestal wat gemakkelijk te meten is—metrics zoals "hallucinatie" en "toxicity"—en niet de specifieke manieren waarop jouw product daadwerkelijk gebruikers in de steek laat.

@HamelHusain en @sh_reya leren een andere aanpak—een die hun cursus de #1 hoogstverdienende op @MavenHQ heeft gemaakt, met constante inschrijvingen van @OpenAI, @AnthropicAI en elk groot AI-lab.

Hun inzicht: Begin met foutenanalyse, niet met metrics.

Beoordeel 100 echte gebruikersinteracties. Schrijf gedetailleerde kritieken over wat er daadwerkelijk misging. Vind patronen. Bouw pas daarna evaluaties die jouw product beter maken.

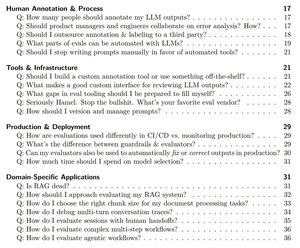

Na het trainen van meer dan 2.000 PM's en ingenieurs bij meer dan 500 bedrijven, hebben ze hun methodologie gedestilleerd tot een systematisch handboek dat je precies laat zien hoe je:

- De ~10 faalmodi identificeert die jouw product daadwerkelijk breken

- LLM-rechters bouwt die je statistisch kunt valideren en vertrouwen

- CI/CD-pijplijnen creëert die regressies opvangen voordat gebruikers dat doen

- Productiemonitoring omzet in een ontdekkingsmachine voor nieuwe problemen

Lees hun complete gids hier:

Boven

Positie

Favorieten