Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hầu hết các đánh giá AI đều là những lời nói dối đắt đỏ.

Chúng thường đo lường những gì dễ đo lường—các chỉ số như "ảo giác" và "độc hại"—chứ không phải những cách cụ thể mà sản phẩm của bạn thực sự thất bại trong việc phục vụ người dùng.

@HamelHusain và @sh_reya dạy một cách tiếp cận khác—một cách đã giúp khóa học của họ trở thành khóa học có doanh thu cao nhất trên @MavenHQ, với sự đăng ký liên tục từ @OpenAI, @AnthropicAI, và mọi phòng thí nghiệm AI lớn.

Nhận thức của họ: Bắt đầu với phân tích lỗi, không phải chỉ số.

Xem xét 100 tương tác thực tế của người dùng. Viết các phê bình chi tiết về những gì thực sự đã sai. Tìm kiếm các mẫu. Chỉ sau đó mới xây dựng các đánh giá giúp sản phẩm của bạn tốt hơn.

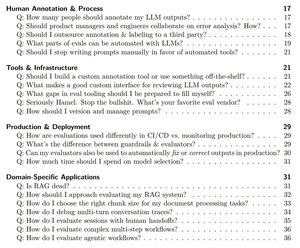

Sau khi đào tạo hơn 2,000 PM và kỹ sư tại hơn 500 công ty, họ đã tinh gọn phương pháp của mình thành một cuốn sách hướng dẫn hệ thống cho bạn biết chính xác cách:

- Xác định khoảng ~10 chế độ thất bại thực sự làm hỏng sản phẩm của bạn

- Xây dựng các thẩm phán LLM mà bạn có thể xác thực và tin tưởng về mặt thống kê

- Tạo các pipeline CI/CD giúp phát hiện các lỗi trước khi người dùng nhận ra

- Biến việc giám sát sản xuất thành một động cơ khám phá cho các vấn đề mới

Đọc hướng dẫn đầy đủ của họ tại đây:

Hàng đầu

Thứ hạng

Yêu thích