Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La mayoría de las evaluaciones de IA son mentiras caras.

Generalmente miden lo que es fácil de medir—métricas como "alucinación" y "toxicidad"—no las formas específicas en que tu producto realmente falla a los usuarios.

@HamelHusain y @sh_reya enseñan un enfoque diferente—uno que ha hecho que su curso sea el más rentable en @MavenHQ, con inscripciones constantes de @OpenAI, @AnthropicAI y cada laboratorio importante de IA.

Su idea: Comienza con el análisis de errores, no con métricas.

Revisa 100 interacciones reales de usuarios. Escribe críticas detalladas de lo que realmente salió mal. Encuentra patrones. Solo entonces construye evaluaciones que mejoren tu producto.

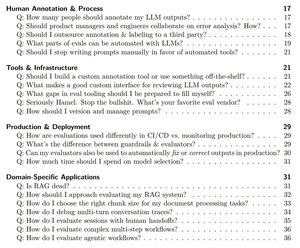

Después de entrenar a más de 2,000 PMs e ingenieros en más de 500 empresas, han destilado su metodología en un manual sistemático que te muestra exactamente cómo:

- Identificar los ~10 modos de falla que realmente rompen tu producto

- Construir jueces de LLM que puedas validar estadísticamente y en los que puedas confiar

- Crear pipelines de CI/CD que detecten regresiones antes que los usuarios

- Convertir la monitorización de producción en un motor de descubrimiento para nuevos problemas

Lee su guía completa aquí:

Parte superior

Clasificación

Favoritos