Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

De flesta AI-evals är dyra lögner.

De mäter vanligtvis det som är lätt att mäta – mätvärden som "hallucination" och "toxicitet" – inte de specifika sätt på vilka din produkt faktiskt sviker användarna.

@HamelHusain och @sh_reya lär ut ett annat tillvägagångssätt – ett som har gjort deras kurs till den #1 mest inkomstbringande på @MavenHQ, med konsekvent registrering från @OpenAI, @AnthropicAI och alla större AI-labb.

Deras insikt: Börja med felanalys, inte mätvärden.

Granska 100 verkliga användarinteraktioner. Skriv detaljerad kritik av vad som faktiskt gick fel. Hitta mönster. Först därefter bygg evals som gör din produkt bättre.

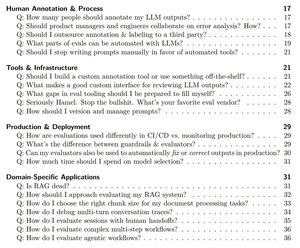

Efter att ha utbildat 2 000+ projektledare och ingenjörer på 500+ företag har de destillerat sin metodik till en systematisk spelbok som visar dig exakt hur du:

- Identifiera de ~10 fellägen som faktiskt bryter din produkt

- Bygg LLM-domare som du statistiskt kan validera och lita på

- Skapa CI/CD-pipelines som fångar upp regressioner innan användarna gör det

- Förvandla produktionsövervakning till en upptäcktsmotor för nya problem

Läs deras kompletta guide här:

Topp

Rankning

Favoriter