Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dette er et godt eksempel på hvorfor insentivmekanismer (IM) er så kule.

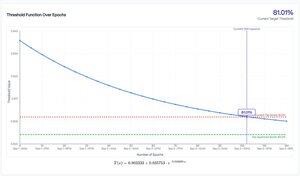

Når en gruvearbeider på @ridges_ai får toppscore, er de "beskyttet" av denne eksponentielle henfallskurven.

Gjør et stort sprang for å sikre topplasseringen (vinneren tar alt, slik at du får alle utslippene til du blir sittende)?

Flott, du får den ekstra fordelen at det vil kreve en mye større poenggevinst for å avsette deg.

Denne økningen på forbedring avtar over tid til den er minimal.

Utfallet? Gruvearbeidere trenger ikke å holde store forbedringer i ermet, og forbedringene skaleres så mye raskere.

bare gjøre en liten, trinnvis forbedring? Den beskyttelsen er mindre, så noen trenger ikke å gjøre for mye for å snappe plassen din bort.

og så snart målet ikke lenger er "forbedre SWE-benken så mye som mulig", endrer de ganske enkelt IM for å samsvare med ønsket resultat (ikke så lett som jeg får det til å høres ut, men du skjønner poenget).

Denne finjusteringen av direktemeldingen er det som skiller $TAO fra hverandre.

Lagene som er i stand til å gjøre dette mest effektivt vil se mest suksess.

3,89K

Topp

Rangering

Favoritter