Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

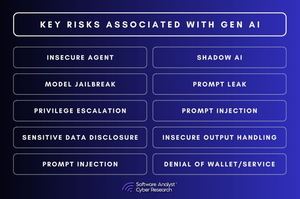

3 прогалини в безпеці штучного інтелекту, які залишають підприємства відкритими!

Розмови про безпеку штучного інтелекту просуваються швидко.

Але є фундаментальні прогалини, які підприємства досі не усунули.

У нашому звіті ми проаналізували ризики безпеки штучного інтелекту в різних галузях і виявили, що більшість підприємств роблять одні й ті ж 3 помилки. І ці прогалини не малі – вони переосмислюють те, як має виглядати кібербезпека у світі, керованому штучним інтелектом.

1. Відсутнє управління штучним інтелектом

Більшість організацій не мають уявлення про те, як штучний інтелект використовується на їхніх підприємствах.

▪️Співробітники впроваджують інструменти штучного інтелекту без схвалення IT.

▪️Команди безпеки не можуть відстежувати, які моделі штучного інтелекту обробляють.

▪️Пілоти зі штучним інтелектом мають більший доступ до корпоративних даних, ніж повинні.

Це не просто проблема відповідності вимогам, а збій у системі безпеки.

Якщо ніхто не володіє безпекою штучного інтелекту, хто несе відповідальність, коли рішення, згенероване штучним інтелектом, йде не так?

2. Моделі штучного інтелекту можна зламати безшумно

Безпека штучного інтелекту працює не так, як традиційна безпека програмного забезпечення.

▪️Замість того, щоб експлуатувати код, зловмисники маніпулюють даними.

▪️Вони впроваджують шкідливі навчальні дані, створюючи безшумні бекдори всередині моделей штучного інтелекту.

▪️Вони тонко налаштовують моделі так, щоб вони поводилися нормально до моменту спрацьовування.

▪️Вони використовують оперативну інженерію для вилучення конфіденційних даних із відповідей штучного інтелекту.

Команди безпеки не можуть сканувати модель штучного інтелекту на наявність шкідливого програмного забезпечення.

І як тільки модель штучного інтелекту буде скомпрометована, ви навіть не дізнаєтесь про це.

3. Безпека під час виконання штучного інтелекту відсутня

Команди безпеки витрачають місяці на захист штучного інтелекту перед розгортанням, але потім припиняють його моніторинг.

Це проблема.

▪️Тому що загрози штучного інтелекту не закінчуються з запуском.

▪️Зловмисники маніпулюють відповідями, згенерованими штучним інтелектом, у режимі реального часу.

▪️Вони вводять підказки, щоб обійти захисні механізми.

▪️Вони використовують API штучного інтелекту, щоб викрадати результати моделей.

І зараз більшість команд безпеки мають мінімальну видимість будь-чого з цього.

Так що ж відбувається далі?

#AI #Cybersecurity #AISecurity #CISO #Automation

2,36K

Найкращі

Рейтинг

Вибране