المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

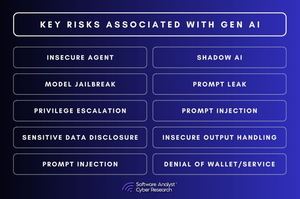

3 ثغرات أمنية في الذكاء الاصطناعي تترك المؤسسات مكشوفة!

تتحرك محادثة أمان الذكاء الاصطناعي بسرعة.

ولكن هناك فجوات أساسية لم تعالجها الشركات بعد.

بالنسبة لتقريرنا ، قمنا بتحليل مخاطر أمان الذكاء الاصطناعي عبر الصناعات ووجدنا أن معظم الشركات ترتكب نفس الأخطاء الثلاثة. وهذه الفجوات ليست صغيرة - فهي تعيد تعريف الشكل الذي يجب أن يبدو عليه الأمن السيبراني في عالم يحركه الذكاء الاصطناعي.

1. حوكمة الذكاء الاصطناعي مفقودة

معظم المؤسسات ليس لديها رؤية لكيفية استخدام الذكاء الاصطناعي داخل مؤسساتها.

▪️يقوم الموظفون بدمج أدوات الذكاء الاصطناعي دون موافقة تكنولوجيا المعلومات.

▪️لا يمكن لفرق الأمان تتبع نماذج الذكاء الاصطناعي التي تعالجها.

▪️يتمتع مساعدو طيارو الذكاء الاصطناعي بوصول أكبر إلى بيانات المؤسسة أكثر مما ينبغي.

هذه ليست مجرد مشكلة امتثال - إنها فشل أمني.

إذا لم يكن أحد يمتلك أمن الذكاء الاصطناعي ، فمن المسؤول عندما يحدث خطأ في قرار تم إنشاؤه بواسطة الذكاء الاصطناعي؟

2. يمكن اختراق نماذج الذكاء الاصطناعي بصمت

لا يعمل أمان الذكاء الاصطناعي مثل أمان البرامج التقليدي.

▪️بدلا من استغلال التعليمات البرمجية ، يتلاعب المهاجمون بالبيانات.

▪️يقومون بحقن بيانات التدريب الضارة مما يخلق أبوابا خلفية صامتة داخل نماذج الذكاء الاصطناعي.

▪️يقومون بضبط النماذج لتتصرف بشكل طبيعي حتى يتم تشغيلها.

▪️يستخدمون الهندسة السريعة لاستخراج البيانات الحساسة من استجابات الذكاء الاصطناعي.

لا يمكن لفرق الأمان فحص نموذج الذكاء الاصطناعي بحثا عن البرامج الضارة.

وبمجرد اختراق نموذج الذكاء الاصطناعي ، لن تعرفه حتى.

3. أمان وقت تشغيل الذكاء الاصطناعي غير موجود

تقضي فرق الأمان شهورا في تأمين الذكاء الاصطناعي قبل النشر - ولكن بعد ذلك تتوقف عن مراقبته.

هذه مشكلة.

▪️لأن تهديدات الذكاء الاصطناعي لا تتوقف عند الإطلاق.

▪️يتلاعب المهاجمون بالاستجابات التي تم إنشاؤها بواسطة الذكاء الاصطناعي في الوقت الفعلي.

▪️إنهم يحقنون مطالبات لتجاوز آليات السلامة.

▪️إنهم يقومون بكشط واجهات برمجة تطبيقات الذكاء الاصطناعي لسرقة مخرجات النموذج.

وفي الوقت الحالي ، تتمتع معظم فرق الأمان برؤية ضئيلة لأي من هذا.

إذن ماذا سيحدث بعد ذلك؟

#الذكاء الاصطناعي #Cybersecurity #AISecurity #CISO #Automation

2.36K

الأفضل

المُتصدِّرة

التطبيقات المفضلة