Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

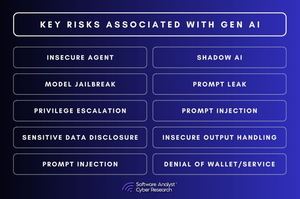

As 3 lacunas de segurança em IA que estão deixando as empresas expostas!

A conversa sobre segurança em IA está avançando rapidamente.

Mas existem lacunas fundamentais que as empresas ainda não abordaram.

Para o nosso relatório, analisamos os riscos de segurança em IA em diversas indústrias e descobrimos que a maioria das empresas está cometendo os mesmos 3 erros. E essas lacunas não são pequenas—estão redefinindo como a cibersegurança precisa ser em um mundo impulsionado por IA.

1. A governança de IA está ausente

A maioria das organizações não tem visibilidade sobre como a IA está sendo utilizada dentro de sua empresa.

▪️Os funcionários estão integrando ferramentas de IA sem a aprovação de TI.

▪️As equipes de segurança não conseguem rastrear quais modelos de IA estão processando.

▪️Os copilotos de IA têm mais acesso aos dados da empresa do que deveriam.

Isso não é apenas um problema de conformidade—é uma falha de segurança.

Se ninguém é responsável pela segurança em IA, quem é responsável quando uma decisão gerada por IA dá errado?

2. Modelos de IA podem ser hackeados silenciosamente

A segurança em IA não funciona como a segurança de software tradicional.

▪️Em vez de explorar o código, os atacantes manipulam dados.

▪️Eles injetam dados de treinamento maliciosos criando portas dos fundos silenciosas dentro dos modelos de IA.

▪️Eles ajustam modelos para se comportarem normalmente até serem acionados.

▪️Eles usam engenharia de prompt para extrair dados sensíveis das respostas da IA.

As equipes de segurança não conseguem escanear um modelo de IA em busca de malware.

E uma vez que um modelo de IA é comprometido, você nem saberá.

3. A segurança em tempo de execução de IA é inexistente

As equipes de segurança passam meses garantindo a segurança da IA antes da implantação—mas depois param de monitorá-la.

Esse é um problema.

▪️Porque as ameaças de IA não param no lançamento.

▪️Os atacantes estão manipulando respostas geradas por IA em tempo real.

▪️Eles estão injetando prompts para contornar mecanismos de segurança.

▪️Eles estão raspando APIs de IA para roubar saídas de modelos.

E, neste momento, a maioria das equipes de segurança tem visibilidade mínima sobre qualquer uma dessas questões.

Então, o que acontece a seguir?

#IA #Cibersegurança #SegurançaIA #CISO #Automação

2,38K

Top

Classificação

Favoritos