Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Mi-a plăcut foarte mult @beffjezos analogia lui @extropic pentru termodinamică în acest podcast

El menționează Demonul 👹 lui Maxwell, o ființă care arde energie pentru a ordona strict moleculele (fierbinți sau reci) în două camere.

Asta m-a ajutat să simt diferența dintre GPU-uri și termodinamică

Cu AI, jucăm Demonul în timp ce forțăm tranzistorii să intre în stări rigide doar pentru a menține un singur parametru. Fiecare este un număr între 0 și 1. Ardem energie masivă în acest proces pentru a lupta cu entropia și a menține aceste numere specifice

Aceasta și numărul masiv de GPU-uri reprezintă motivul pentru care avem nevoie de reactoare nucleare și cantități uriașe de energie pentru a funcționa centre de date

Matematic, un parametru este fix, dar fizic, menținerea acelei precizii este o luptă constantă împotriva căldurii. Cipurile digitale trebuie să consume o energie masivă pentru a amplifica semnalul peste zgomotul termic natural, doar pentru a preveni randomizarea datelor. De aceea facturile de energie devin Brrrr la GPU-uri

Calculul termodinamic încetează să mai lupte cu fizica. Tratează fluctuațiile termice ca pe o resursă, nu ca pe o eroare, și le folosește pentru a eșantiona natural distribuția. E total diferit.

În loc să folosim energia de masă pentru a menține cifre stricte și să sprijinim acest haos/aleatorietate, putem rula modele AI la ordine de mărime mai mică energie

Asta ne scoate din trenul nesfârșit de putere/calcul pe care îl avem acum pentru AI

Sunt la începutul cercetării mele aici, deci probabil am greșit ceva

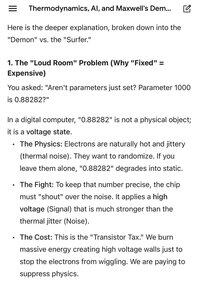

Pozele atașate sunt o comparație foarte utilă făcută de Gemini privind diferența dintre digital și termic

Limită superioară

Clasament

Favorite