Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

J'ai vraiment apprécié l'analogie de @beffjezos de @extropic sur la thermodynamique dans ce podcast

Il mentionne le Démon de Maxwell 👹, un être qui brûle de l'énergie pour ordonner strictement les molécules (chaudes ou froides) dans deux pièces.

Cela m'a aidé à comprendre la différence entre les GPU/thermo.

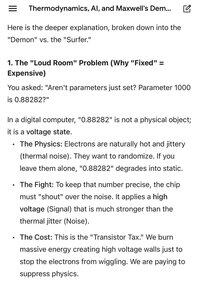

Avec l'IA, nous jouons le rôle du Démon en forçant les transistors dans des états rigides juste pour maintenir un seul paramètre. Chacun est un nombre entre 0 et 1. Nous brûlons une énergie massive dans le processus pour lutter contre l'entropie et maintenir ces nombres spécifiques.

C'est pourquoi, avec le nombre massif de GPU, nous avons besoin de réacteurs nucléaires et de grandes quantités d'énergie pour faire fonctionner les centres de données.

Mathématiquement, un paramètre est fixe, mais physiquement, maintenir cette précision est un combat constant contre la chaleur. Les puces numériques doivent brûler une énergie massive pour amplifier le signal au-dessus du bruit thermique naturel juste pour empêcher les données de se randomiser. C'est pourquoi les factures d'énergie explosent avec les GPU.

L'informatique thermodynamique cesse de lutter contre la physique. Elle traite les fluctuations thermiques comme une ressource plutôt que comme une erreur et les utilise pour échantillonner naturellement la distribution. C'est totalement différent.

Au lieu d'utiliser une énergie massive pour maintenir des nombres stricts et de s'appuyer sur ce chaos/hasard, nous pouvons faire fonctionner des modèles d'IA avec des ordres de grandeur d'énergie en moins.

Cela nous sort du train de puissance/calcul sans fin sur lequel nous sommes actuellement pour l'IA.

Je suis au début de mes recherches ici, donc j'ai probablement fait des erreurs.

Les images jointes sont une comparaison vraiment utile par Gemini sur la différence entre le numérique et le thermique.

Meilleurs

Classement

Favoris