Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Naprawdę podobała mi się analogia @beffjezos z @extropic na temat termodynamiki w tym podcaście

Wspomina o Demonach Maxwella 👹, istocie, która spala energię, aby ściśle uporządkować cząsteczki (gorące lub zimne) w dwóch pomieszczeniach.

To pomogło mi zrozumieć różnicę między GPU/Termo

Z AI gramy w Demona, zmuszając tranzystory do sztywnych stanów tylko po to, aby utrzymać jeden parametr. Każdy z nich to liczba między 0 a 1. Spalamy ogromne ilości energii w tym procesie, aby walczyć z entropią i utrzymać te konkretne liczby.

To oraz ogromna liczba GPU to powód, dla którego potrzebujemy reaktorów jądrowych i ogromnych ilości energii do zasilania centrów danych.

Matematycznie parametr jest stały, ale fizycznie utrzymanie tej precyzji to ciągła walka z ciepłem. Cyfrowe układy muszą spalać ogromne ilości energii, aby wzmocnić sygnał ponad naturalny szum termiczny, aby zapobiec losowości danych. Dlatego rachunki za energię rosną Brrrr z GPU.

Obliczenia termodynamiczne przestają walczyć z fizyką. Traktuje fluktuacje termiczne jako zasób, a nie błąd, i wykorzystuje je do naturalnego próbkowania rozkładu. To zupełnie coś innego.

Zamiast używać masowej energii do utrzymywania ścisłych liczb i polegać na tym chaosie/losowości, możemy uruchamiać modele AI przy rzędy wielkości mniejszym zużyciu energii.

To wyprowadza nas z niekończącego się pociągu mocy/obliczeń, na którym obecnie jesteśmy w przypadku AI.

Jestem na początku moich badań w tej dziedzinie, więc prawdopodobnie coś pomyliłem.

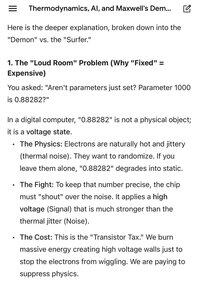

Załączone zdjęcia to naprawdę pomocne porównanie od Gemini dotyczące różnicy między cyfrowym a termicznym.

Najlepsze

Ranking

Ulubione