Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ich habe die Analogie von @beffjezos von @extropic zur Thermodynamik in diesem Podcast wirklich genossen.

Er erwähnt Maxwells Dämon 👹, ein Wesen, das Energie verbrennt, um Moleküle (heiß oder kalt) strikt in zwei Räume zu ordnen.

Das hat mir geholfen, den Unterschied zwischen GPUs/Thermo zu verstehen.

Mit KI spielen wir den Dämon, während wir Transistoren in starre Zustände zwingen, nur um einen einzelnen Parameter zu halten. Jeder ist eine Zahl zwischen 0 und 1. Wir verbrennen massive Energie in diesem Prozess, um der Entropie entgegenzuwirken und diese spezifischen Zahlen zu halten.

Das und die massive Anzahl an GPUs ist der Grund, warum wir Kernreaktoren und riesige Energiemengen benötigen, um Rechenzentren zu betreiben.

Mathematisch ist ein Parameter festgelegt, aber physisch ist das Halten dieser Präzision ein ständiger Kampf gegen die Wärme. Digitale Chips müssen massive Energie verbrennen, um das Signal über das natürliche thermische Rauschen zu verstärken, nur um zu verhindern, dass die Daten randomisiert werden. Das ist der Grund, warum die Energiekosten mit GPUs Brrrr gehen.

Die thermodynamische Berechnung hört auf, gegen die Physik zu kämpfen. Sie behandelt thermische Fluktuationen als Ressource und nicht als Fehler und nutzt sie, um die Verteilung natürlich zu sampeln. Es ist völlig anders.

Anstatt massive Energie zu verwenden, um strikte Zahlen zu halten und in dieses Chaos/Zufälligkeit zu drängen, können wir KI-Modelle mit um Größenordnungen weniger Energie betreiben.

Das bringt uns von dem endlosen Energie-/Rechenzentrums-Zug, auf dem wir jetzt für KI sind.

Ich stehe am Anfang meiner Forschung hier, also habe ich wahrscheinlich etwas falsch gemacht.

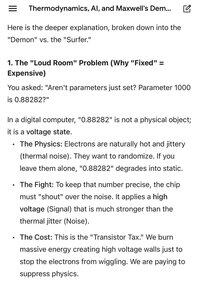

Die angehängten Bilder sind ein wirklich hilfreicher Vergleich von Gemini über den Unterschied zwischen digital und thermisch.

Top

Ranking

Favoriten