Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ik heb echt genoten van de analogie van @beffjezos van @extropic over thermodynamica in deze podcast.

Hij noemt Maxwell's Demon 👹, een wezen dat energie verbrandt om moleculen (heet of koud) strikt in twee kamers te ordenen.

Dit hielp me het verschil tussen GPU's/Thermo te begrijpen.

Met AI spelen we de Demon terwijl we transistors dwingen in rigide toestanden om slechts één parameter vast te houden. Elk is een getal tussen 0 en 1. We verbranden enorme hoeveelheden energie in het proces om entropie te bestrijden en deze specifieke getallen te behouden.

Dit en het enorme aantal GPU's is waarom we nucleaire reactoren en enorme hoeveelheden energie nodig hebben om datacenters te laten draaien.

Wiskundig gezien is een parameter vast, maar fysiek gezien is het vasthouden aan die precisie een constante strijd tegen warmte. Digitale chips moeten enorme energie verbranden om het signaal boven de natuurlijke thermische ruis te versterken, alleen al om te voorkomen dat de gegevens willekeurig worden. Dit is waarom energiekosten met GPU's Brrrr gaan.

Thermodynamisch rekenen stopt met het bestrijden van de natuurkunde. Het beschouwt thermische fluctuaties als een hulpbron in plaats van een fout en gebruikt ze om natuurlijk de verdeling te bemonsteren. Het is totaal anders.

In plaats van massa-energie te gebruiken om strikte getallen te behouden en in deze chaos/willekeurigheid te leunen, kunnen we AI-modellen draaien met een orde van grootte minder energie.

Dit haalt ons van de eindeloze stroom/rekentrain waarop we nu zitten voor AI.

Ik ben aan het begin van mijn onderzoek hier, dus ik heb waarschijnlijk iets verkeerd.

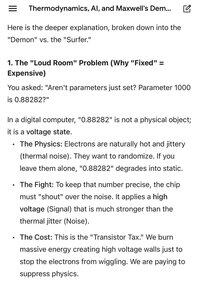

De bijgevoegde afbeeldingen zijn een echt nuttige vergelijking door Gemini over het verschil tussen digitaal en thermisch.

Boven

Positie

Favorieten