熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

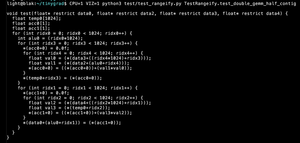

這有點埋藏了重點,重點是透過一個小改變,你也可以在 NxN 矩陣上進行 ReLU(A @ B) @ C,並且有 N 個中介而不需要重新計算。

(也就是:一個神經網絡。)

8月8日 23:42

每個人都知道 Flash Attention。但你知道 Flash GEMM 嗎?

這段代碼計算 NxN 矩陣上的 (A @ B) @ C,並且有 N 個中介,且不需要重新計算。如果你不使用 BLAS 庫,你不需要具現化中介矩陣。

25.38K

熱門

排行

收藏