Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

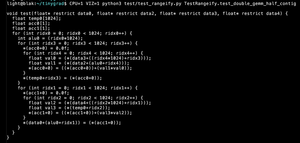

Esto está enterrando un poco el tema principal, que es que con un cambio menor también puedes hacer ReLU(A @ B) @ C en matrices NxN con N intermedios y sin recomputación.

(esto es: una red neuronal.)

8 ago, 23:42

Todo el mundo conoce Flash Attention. Pero, ¿sabes sobre Flash GEMM?

Este código calcula (A @ B) @ C en matrices NxN con N intermedios y sin recomputación. Si no usas una biblioteca BLAS, no necesitas materializar la matriz intermedia.

25.4K

Populares

Ranking

Favoritas