Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Trochę to ukrywa sedno sprawy, a mianowicie, że przy drobnej zmianie możesz również wykonać ReLU(A @ B) @ C na macierzach NxN z N pośrednikami i bez ponownego obliczania.

(znane również jako: sieć neuronowa.)

8 sie, 23:42

Everyone knows about Flash Attention. But do you know about Flash GEMM?

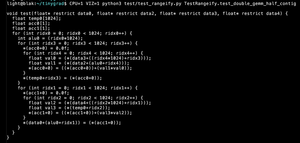

This code computes (A @ B) @ C on NxN matrices with N intermediates and no recomputation. If you don't use a BLAS library, you don't need to materialize the intermediate matrix.

25,39K

Najlepsze

Ranking

Ulubione