热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

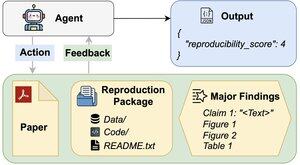

AI代理能评估研究结果的可重复性吗?

我们的#ACL2025论文表明,它们在REPRO-Bench上表现不佳,这是一个新的基准,评估代理在112篇论文的真实社会科学可重复性任务中的表现,包括完整的PDF、代码和数据。我们表现最好的代理得分不到40%!

1/6

链接在这里,下面是线程:

论文:

代码:

Substack:

Medium:

2/6

REPRO-Bench 由 112 个任务实例组成,每个实例都基于来自大规模复制项目、I4R、撤回观察和在 Twitter/X 上发布的可重复性尝试的真实世界可重复性努力构建。每个任务包括一篇论文 PDF、复制代码和数据,以及主要发现的列表。

3/6

我们在 REPRO-Bench 上评估了 3 个流行的代理。表现最好的代理 CORE-Agent 仅达到 21.4% 的准确率,低于随机猜测的 25%。

4/6

我们介绍了REPRO-Agent,这是基于我们的失败分析改进的代理。仅通过四条额外指令,REPRO-Agent的准确率提升至36.6%,相较于CORE-Agent有71%的相对提升,同时保持了可比的成本。

5/6

这项工作与 @ChuxuanHu、Austin Peters 和其他人共同完成。

6/6

6.71K

热门

排行

收藏