Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

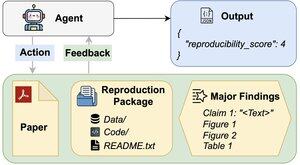

Kunnen AI-agenten de reproduceerbaarheid van onderzoeksresultaten beoordelen?

Ons #ACL2025-papier toont aan dat ze tekortschieten met REPRO-Bench, een nieuwe benchmark die agenten evalueert op echte sociale wetenschappelijke reproduceerbaarheidstaken van 112 artikelen, volledige PDF's, code en data. Onze best presterende agent scoort <40%!

1/6

Links hier en thread hieronder:

Paper:

Code:

Substack:

Medium:

2/6

REPRO-Bench bestaat uit 112 taakinstanties, elk opgebouwd uit echte inspanningen voor reproduceerbaarheid afkomstig van massareproductieprojecten, I4R, Retraction Watch en pogingen tot reproduceerbaarheid die op Twitter/X zijn geplaatst. Elke taak bevat een paper PDF, reproductiecode en -gegevens, en een lijst van belangrijke bevindingen.

3/6

We evalueren 3 populaire agenten op REPRO-Bench. De best presterende agent, CORE-Agent, behaalt slechts 21,4% nauwkeurigheid, wat lager is dan willekeurig gokken (25%).

4/6

We introduceren REPRO-Agent, een verbeterde agent gebaseerd op onze faalanalyse. Met slechts vier extra instructies verhoogt REPRO-Agent de nauwkeurigheid tot 36,6%, een relatieve verbetering van 71% ten opzichte van de CORE-Agent, terwijl de kosten vergelijkbaar blijven.

5/6

Dit werk is gezamenlijk met @ChuxuanHu, Austin Peters en anderen.

6/6

6,72K

Boven

Positie

Favorieten