Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

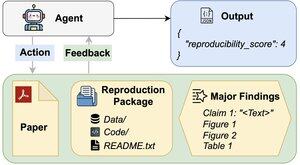

Pot agenții AI să evalueze reproductibilitatea rezultatelor cercetării?

Lucrarea noastră de #ACL2025 arată că nu sunt la REPRO-Bench, un nou punct de referință care evaluează agenții pe sarcini de reproductibilitate din științele sociale din lumea reală a 112 lucrări, PDF-uri complete, cod și date. Cel mai performant scor al nostru de agent <40%!

1/6

Link-uri aici și firul de mai jos:

Hârtie:

Cod:

Substivă:

Medie:

2/6

REPRO-Bench constă din 112 instanțe de sarcini, fiecare construită din eforturi de reproductibilitate din lumea reală provenite din proiecte de reproducere în masă, I4R, Retraction Watch și încercări de reproductibilitate postate pe Twitter/X. Fiecare sarcină include un PDF pe hârtie, cod și date de reproducere și o listă de constatări majore.

3/6

Evaluăm 3 agenți populari pe REPRO-Bench. Cel mai performant agent, CORE-Agent, atinge o precizie de doar 21,4%, ceea ce este mai mic decât ghicirea aleatorie (25%).

4/6

Introducem REPRO-Agent, un agent îmbunătățit pe baza analizei noastre de eșec. Cu doar patru instrucțiuni suplimentare, REPRO-Agent crește precizia la 36,6%, o îmbunătățire relativă de 71% față de CORE-Agent, menținând în același timp costuri comparabile.

5/6

Această lucrare este comună cu @ChuxuanHu, Austin Peters și alții.

6/6

6,74K

Limită superioară

Clasament

Favorite