Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

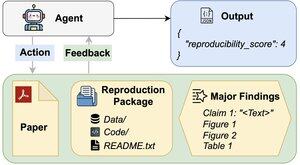

Các tác nhân AI có thể đánh giá khả năng tái tạo của các kết quả nghiên cứu không?

Bài báo #ACL2025 của chúng tôi cho thấy rằng họ không đạt được REPRO-Bench, một tiêu chuẩn mới đánh giá các tác nhân về các nhiệm vụ tái tạo khoa học xã hội trong thế giới thực của 112 bài báo, PDF đầy đủ, mã và dữ liệu. Điểm đại lý hiệu suất cao nhất của chúng tôi <40%!

1/6

Liên kết ở đây và chủ đề bên dưới:

Giấy:

Mã:

Substack:

Medium:

2/6

REPRO-Bench bao gồm 112 trường hợp nhiệm vụ, mỗi trường hợp được xây dựng từ những nỗ lực tái sản xuất thực tế được lấy từ các dự án tái sản xuất hàng loạt, I4R, Retraction Watch và các nỗ lực tái sản xuất được đăng trên Twitter/X. Mỗi nhiệm vụ bao gồm một PDF bài báo, mã & dữ liệu tái sản xuất, và một danh sách các phát hiện chính.

3/6

Chúng tôi đánh giá 3 tác nhân phổ biến trên REPRO-Bench. Tác nhân có hiệu suất tốt nhất, CORE-Agent, chỉ đạt 21,4% độ chính xác, thấp hơn cả việc đoán ngẫu nhiên (25%).

4/6

Chúng tôi giới thiệu REPRO-Agent, một tác nhân cải tiến dựa trên phân tích thất bại của chúng tôi. Chỉ với bốn hướng dẫn bổ sung, REPRO-Agent nâng cao độ chính xác lên 36,6%, cải thiện 71% so với CORE-Agent, trong khi vẫn duy trì chi phí tương đương.

5/6

Công việc này là sự hợp tác với @ChuxuanHu, Austin Peters và những người khác.

6/6

6,72K

Hàng đầu

Thứ hạng

Yêu thích