トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AI エージェントは研究結果の再現性を評価できますか?

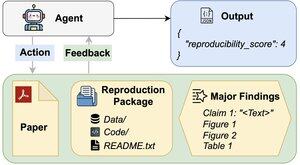

私たちの #ACL2025 論文では、112 の論文、完全な PDF、コード、およびデータの実際の社会科学の再現性タスクでエージェントを評価する新しいベンチマークである REPRO-Bench では不十分であることが示されています。最もパフォーマンスの高いエージェントのスコアは<40%です。

1/6

リンクはこちら、スレッドは以下のとおりです。

紙:

コード:

サブスタック:

中程度:

2/6

REPRO-Benchは112のタスクインスタンスで構成されており、それぞれが大量複製プロジェクト、I4R、Retraction Watch、およびTwitter/Xに投稿された再現性の試みから得られた現実世界の再現性の取り組みから構築されています。各タスクには、紙のPDF、複製コードとデータ、および主要な調査結果のリストが含まれます。

3/6

REPRO-Benchで3つの人気のある薬剤を評価します。最もパフォーマンスの高いエージェントである CORE-Agent の精度は 21.4% にとどまり、ランダム推測 (25%) よりも低くなります。

4/6

故障解析をもとに改良した薬剤「REPRO-Agent」をご紹介します。REPRO-Agentは、わずか4つの追加命令で、同等のコストを維持しながら、精度を36.6%に向上させ、CORE-Agentよりも71%相対的に向上します。

5/6

この作品は、@ChuxuanHu、オースティン・ピーターズらと共同で制作されています。

6/6

6.71K

トップ

ランキング

お気に入り