Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Können KI-Agenten die Reproduzierbarkeit von Forschungsergebnissen bewerten?

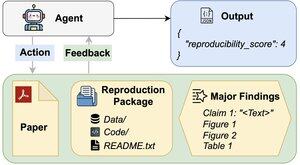

Unser #ACL2025-Papier zeigt, dass sie mit REPRO-Bench, einem neuen Benchmark, das Agenten bei realen Aufgaben zur Reproduzierbarkeit in den Sozialwissenschaften von 112 Arbeiten, vollständigen PDFs, Code und Daten bewertet, hinter den Erwartungen zurückbleiben. Unser leistungsstärkster Agent erzielt <40%!

1/6

Links hier und Thread unten:

Papier:

Code:

Substack:

Medium:

2/6

REPRO-Bench besteht aus 112 Aufgabeninstanzen, die jeweils aus realen Reproduzierbarkeitsbemühungen stammen, die aus Massenreproduktionsprojekten, I4R, Retraction Watch und Reproduzierbarkeitsversuchen, die auf Twitter/X veröffentlicht wurden, gewonnen wurden. Jede Aufgabe umfasst ein Papier-PDF, Reproduktionscode & Daten sowie eine Liste der wichtigsten Ergebnisse.

3/6

Wir bewerten 3 beliebte Agenten auf REPRO-Bench. Der leistungsstärkste Agent, CORE-Agent, erreicht nur 21,4 % Genauigkeit, was niedriger ist als zufälliges Raten (25 %).

4/6

Wir stellen REPRO-Agent vor, einen verbesserten Agenten basierend auf unserer Fehleranalyse. Mit nur vier zusätzlichen Anweisungen erhöht REPRO-Agent die Genauigkeit auf 36,6 %, was eine relative Verbesserung von 71 % gegenüber dem CORE-Agent darstellt, während die Kosten vergleichbar bleiben.

5/6

Diese Arbeit ist gemeinsam mit @ChuxuanHu, Austin Peters und anderen entstanden.

6/6

6,71K

Top

Ranking

Favoriten