Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

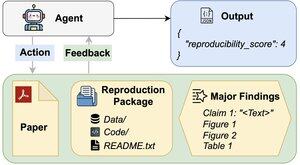

Mohou agenti umělé inteligence posoudit reprodukovatelnost výsledků výzkumu?

Náš #ACL2025 článek ukazuje, že zaostávají za REPRO-Bench, novým benchmarkem, který hodnotí agenty v reálných úlohách reprodukovatelnosti společenských věd ze 112 článků, plných PDF, kódu a dat. Náš nejvýkonnější agent má skóre <40 %!

1/6

Odkazy zde a vlákno níže:

Papír:

Kód:

Dílčí zásobník:

Středně:

2/6

REPRO-Bench se skládá ze 112 instancí úloh, z nichž každá je vytvořena na základě reálných snah o reprodukovatelnost pocházejících z projektů hromadné reprodukce, I4R, Retraction Watch a pokusů o reprodukovatelnost zveřejněných na Twitteru/X. Každý úkol obsahuje papírové PDF, reprodukční kód a data a seznam hlavních zjištění.

3/6

Hodnotíme 3 oblíbené agenty na REPRO-Bench. Nejvýkonnější agent, CORE-Agent, dosahuje přesnosti pouze 21,4 %, což je méně než náhodné odhadování (25 %).

4/6

Představujeme REPRO-Agent, vylepšený prostředek založený na naší analýze poruch. S pouhými čtyřmi dalšími instrukcemi REPRO-Agent zvyšuje přesnost na 36,6 %, což je 71% relativní zlepšení oproti CORE-Agent, při zachování srovnatelných nákladů.

5/6

Tato práce je společná s @ChuxuanHu, Austinem Petersem a dalšími.

6/6

6,72K

Top

Hodnocení

Oblíbené