Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

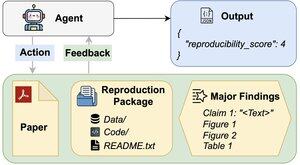

Os agentes de IA podem avaliar a reprodutibilidade das descobertas de pesquisa?

O nosso artigo #ACL2025 mostra que eles ficam aquém com o REPRO-Bench, um novo benchmark que avalia agentes em tarefas de reprodutibilidade de ciências sociais do mundo real de 112 artigos, PDFs completos, código e dados. O nosso agente de melhor desempenho marca <40%!

1/6

Links aqui e thread abaixo:

Paper:

Code:

Substack:

Medium:

2/6

O REPRO-Bench consiste em 112 instâncias de tarefas, cada uma construída a partir de esforços de reprodutibilidade do mundo real, provenientes de projetos de reprodução em massa, I4R, Retraction Watch e tentativas de reprodutibilidade publicadas no Twitter/X. Cada tarefa inclui um PDF do artigo, código e dados de reprodução, e uma lista das principais descobertas.

3/6

Avaliamo 3 agentes populares no REPRO-Bench. O agente com melhor desempenho, CORE-Agent, alcança apenas 21,4% de precisão, que é inferior ao palpite aleatório (25%).

4/6

Apresentamos o REPRO-Agent, um agente melhorado com base na nossa análise de falhas. Com apenas quatro instruções adicionais, o REPRO-Agent aumenta a precisão para 36,6%, uma melhoria relativa de 71% em relação ao CORE-Agent, mantendo um custo comparável.

5/6

Este trabalho é conjunto com @ChuxuanHu, Austin Peters e outros.

6/6

6,73K

Top

Classificação

Favoritos