热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Artificial Analysis

独立分析 AI 模型和托管提供商 - 为您的用例选择最佳模型和 API 提供商

DeepSeek推出V3.1,将V3和R1统一为一个混合推理模型,智能水平逐步提升

智能水平逐步提升:DeepSeek V3.1的初步基准测试结果显示,推理模式下的人工分析智能指数为60,较R1的59有所上升。在非推理模式下,V3.1的得分为49,较早期的V3 0324得分44有了更大的提升。这使得V3.1(推理)落后于阿里巴巴最新的Qwen3 235B 2507(推理)——DeepSeek尚未重新夺回领先地位。

混合推理:@deepseek_ai首次采用混合推理模型,支持推理和非推理模式。DeepSeek转向统一的混合推理模型模仿了OpenAI、Anthropic和Google的做法。然而,值得注意的是,阿里巴巴最近放弃了他们之前偏好的混合方法,分别发布了Qwen3 2507推理和指令模型。

功能调用/工具使用:虽然DeepSeek声称模型的功能调用有所改善,但DeepSeek V3.1在推理模式下不支持功能调用。这可能会大大限制其支持具有智能要求的代理工作流程的能力,包括在编码代理中的应用。

令牌使用:DeepSeek V3.1在推理模式下的得分比DeepSeek R1略高,并且在我们用于人工分析智能指数的评估中使用的令牌略少。在非推理模式下,它使用的令牌比V3 0324略多——但仍然是其推理模式使用的令牌的几倍。

API:DeepSeek的第一方API现在在他们的聊天和推理端点上服务于新的DeepSeek V3.1模型——只需在聊天模板中更改是否提供结束思考</think>令牌,以控制模型是否进行推理。

架构:DeepSeek V3.1在架构上与之前的V3和R1模型完全相同,具有671B的总参数和37B的活跃参数。

影响:我们建议在对这一发布所暗示的DeepSeek在未来模型(传闻称为V4或R2)进展方面做出任何假设时保持谨慎。我们注意到,DeepSeek之前在2024年12月10日发布了基于其V2架构的最终模型,仅在发布V3的两周前。

71.23K

宣布人工分析长上下文推理(AA-LCR),这是一个新的基准,用于通过测试多个长文档(~100k tokens)的推理能力来评估长上下文性能。

AA-LCR的重点是复制真实的知识工作和推理任务,测试对现代AI应用至关重要的能力,涵盖文档分析、代码库理解和复杂的多步骤工作流程。

AA-LCR包含100个基于文本的困难问题,这些问题需要在多个代表~100k输入tokens的真实世界文档中进行推理。问题的设计使得答案不能直接找到,而必须从多个信息源中推理得出,人工测试验证每个问题确实需要真实的推理而非检索。

关键要点:

➤ 今天的领先模型实现了~70%的准确率:前三名分别是OpenAI o3(69%)、xAI Grok 4(68%)和Qwen3 235B 2507 Thinking(67%)

➤👀 我们也已经有了gpt-oss的结果!120B的表现接近o4-mini(高),与OpenAI关于模型性能的声明一致。我们将很快跟进模型的智能指数。

➤ 100个基于文本的困难问题,涵盖7类文档(公司报告、行业报告、政府咨询、学术界、法律、市场材料和调查报告)

➤ 每个问题约需~100k tokens的输入,要求模型支持至少128K的上下文窗口才能在此基准上得分

➤ 运行基准所需的总独特输入tokens约为~3M,涵盖~230个文档(输出tokens通常因模型而异)

➤ 数据集链接在🤗 @HuggingFace下方

我们将AA-LCR添加到人工分析智能指数,并将版本号提升至v2.2。人工分析智能指数v2.2现在包括:MMLU-Pro、GPQA Diamond、AIME 2025、IFBench、LiveCodeBench、SciCode和AA-LCR。

所有数字现在已在网站上更新。查看哪些模型在人工分析智能指数v2.2中表现优异👇

28.97K

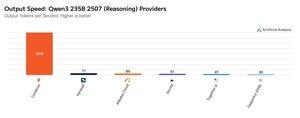

Cerebras 本周一直在展示其以非常高的速度托管大型 MoE 的能力,以 >1,500 个输出令牌/秒的速度推出 Qwen3 235B 2507 和 Qwen3 Coder 480B 端点

➤ @CerebrasSystems 现在为 Qwen3 235B 2507 推理和非推理提供端点。两种型号的总参数均为 235B,其中 22B 处于活动状态。

➤ Qwen 3 235B 2507 Reasoning 提供可与 o4-mini(高)和 DeepSeek R1 0528 相媲美的智能。非推理变体提供的智能可与 Kimi K2 相媲美,远高于 GPT-4.1 和 Llama 4 Maverick。

➤ Qwen3 Coder 480B 总参数为 480B,其中 35B 处于活动状态。该模型对于代理编码特别强大,可用于各种编码代理工具,包括 Qwen3-Coder CLI。

Cerebras 的发布代表了这种智能水平首次以这样的输出速度实现,并有可能解锁新的用例——例如为代理的每个步骤使用推理模型,而无需等待几分钟。

25.39K

热门

排行

收藏